[sommaire]

Ce texte a été écrit en 1989 alors que l’auteur purgeait une peine de quinze ans de prison dans le pénitencier de Rochester aux Etats-Unis. L’incarcération de l’économiste Lyndon LaRouche faisait suite à une chasse aux sorcières menée contre lui et plusieurs de ses collaborateurs. L’ancien ministre de la Justice sous l’administration Johnson, le très respecté Ramsey Clark, raconte, qu’à sa connaissance, la condamnation de LaRouche a mobilisé les plus grands moyens de police et de justice américains, en toute mauvaise foi et aux fins d’éliminer un ennemi politique.

Cette vendetta politique a été menée en particulier par l’entourage de George Bush père ainsi que certains milieux de Wall Street. En effet, comme l’a expliqué le Wall Street Journal du19 septembre 1997, « M. LaRouche est depuis longtemps en lutte avec la classe politique américaine qui le considère extrémiste en raison de ses propositions de réforme du système financier international ». Ses propositions « extrémistes » consistent, en fait, à abandonner la politique d’usure mise en place par le Fonds monétaire international et revenir à un système monétaire similaire à celui de Bretton Woods. Dans la tradition de Franklin Delano Roosevelt, LaRouche défend également une politique ambitieuse de grands projets infrastructurels pour les pays de l’Est et du Sud.

LaRouche a été libéré sur parole en 1994, peu de temps après l’élection de Bill Clinton à la présidence.

Ibykus revisité [1]

Le 19 avril 1989. Un bon vent m’a apporté quelques dialogues de Platon dans ma cellule. Depuis la prison dans laquelle s’achève la carrière de l’homme politique, l’influence de l’homme d’Etat atteint le sommet du cours providentiel de son existence. Depuis Solon, la méthode socratique est devenue la marque des grands hommes d’Etat occidentaux. Sans la réapparition d’un leadership de ce genre, notre civilisation en péril ne survivra pas aux dernières années de ce siècle.

Les traductions de Platon auxquelles j’ai eu accès étaient dignes des falsifications de Benjamin Jowett : il s’agit de quelques dialogues issus d’une édition concoctée récemment par la collection Penguin Classics. Je voudrais soulever ici une question cruciale liée à la traduction du Théétète par Robin Waterford [2].

En page 23, Waterford traduit ainsi cet extrait :

Théétète : [...] les nombres qui peuvent être formés par la multiplication de facteurs égaux, nous les avons représentés sous la figure du carré et les avons appelés "carrés et équilatères".

Sachons faire bon usage de l’ineptie que Waterford introduit dans la note de bas de page qui accompagne ce passage : « L’un des termes de Théétète ["carré et équilatère"] est redondant [sic !]. Cette légère maladresse, ainsi que quelques autres dans son exposé, a été voulue pour suggérer le fait que l’on dépeint un écolier et non pas un mathématicien accompli. »

Ce qui nous intéresse ici, c’est la bévue mathématique de Waterford. Elle montre que l’auteur de cette traduction est incapable de saisir le fil essentiel de l’argument qui articule ce passage du dialogue.

L’élaboration d’une définition géométrique préliminaire des grandeurs irrationnelles montre qu’il existe des cas pour lesquels l’examen critique d’une traduction (en anglais, par exemple) n’a pas besoin d’avoir en référence le texte grec original. Nous allons voir que cela peut également être le cas pour les idées platoniciennes en général, et pour la notion même de méthode socratique.

Dans l’essai qui accompagne sa traduction, Waterford s’efforce surtout de discréditer la méthode socratique et les idées platoniciennes. Le masque du traducteur est tombé. En fait, d’une manière plus générale, l’empirisme britannique et l’héritage néokantien de Marbourg ont acquis, dans le monde anglophone d’aujourd’hui, un monopole de soi-disant autorité intellectuelle sur les questions académiques liées à la traduction et à l’interprétation de l’œuvre de Platon.

Le texte grec original a, à juste titre, une fonction spécifique irremplaçable. C’est une composante essentielle de l’histoire vivante de la civilisation de ce siècle et des suivants. C’est un élément central de l’ensemble de l’histoire de la Grèce classique ; c’est une caractéristique centrale de l’histoire universelle de ces deux mille cinq cents dernières années ; il joue un rôle prépondérant dans le développement de la philologie indoeuropéenne classique. Néanmoins, nous voulons, ici, nous concentrer sur des conceptions qui sont susceptibles d’une représentation intelligible complète, en prenant pour référence les éditions anglaises comme si les textes grecs n’existaient plus.

Le cas en question (la définition géométrique des irrationnels simples donnée par Théétète) est un exemple rudimentaire du sujet qui nous intéresse. Chaque fois que Platon utilise des mots pour décrire une conception qu’il pense devoir être également représentée par des méthodes de géométrie constructive, la géométrie constructive nous fournit une base rigoureuse pour critiquer la manière dont l’édition anglaise traite cet aspect du dialogue [3].

Il se trouve que toutes les idées platoniciennes s’inscrivent dans la classe des représentations intelligibles construites de façon géométrique [4]. C’est également vrai pour la méthode socratique elle-même. Les pages qui suivent vont illustrer ce point. Ces pages ne sont pas une répétition du Théétète, elles lui servent de complément d’une manière qui sera plus claire en comparant directement les deux textes.

Qu’entend-on par « sens commun » ?

Il y a peut-être quelque vérité dans le vieux dicton selon lequel l’herbe est toujours plus verte dans le jardin du voisin. Au cours de mes soixante-six années, j’ai pu constater que ceux qui vantaient le sens commun le plus haut et le plus fort se sont avérés posséder très peu de cette virtù particulière. A tel point que d’autres, autour de moi, avaient honte de défendre le sens commun sous son nom véritable.

Il semble parfois que les perspectives d’avenir du sens commun soient à peu près les mêmes que celles de la race éteinte des dodos. Nous avons sans doute ici l’une des dernières occasions à saisir pour le sauver avant que notre nation ne disparaisse à son tour. Prenons donc ouvertement la défense du sens commun sous son nom véritable. Elaborons à cette fin une définition acceptable de cette expression.

Commençons par prendre deux résolutions simples. D’abord, nous ne devons pas hésiter à écarter toute connotation de « bon sens paysan » ; l’image de nettoyer le tapis du salon avec une fourche nous confirme dans cette résolution. Il devrait être évident que nous devons aussi rejeter toute définition dont les axiomes reposent sur la notion d’une personne individuelle « suffisamment intelligente pour survivre ». Les sociétés peuvent être ou ne pas être immortelles ; aucun individu ne l’est.

Nous avons besoin d’une définition qui n’indique pas seulement les préconditions nécessaires à la survie réussie de sociétés entières. Cette définition doit également inclure la preuve qu’une certaine qualité, que posséderaient au moins certaines personnes impliquées dans le processus décisionnel de cette société, est indispensable pour la survie réussie de l’ensemble de cette société.

La survie ne constitue-t-elle pas en tant que telle la réussite ? Il existe certains états de sociétés qui peuvent ressembler à une survie momentanée mais qui s’avèrent être une étape de progrès sur un chemin menant à la ruine sur le long terme.

Quelle que soit la définition que l’on donne au « sens commun », le terme « commun » signifie qu’une société a peu de chance de parvenir à une survie réussie si le « sens commun » n’y est pas plus ou moins communément répandu. Cela n’est pas contradictoire avec ce qu’exprimaient plusieurs des pères fondateurs de notre république fédérale, en disant qu’une certaine qualité d’éducation publique universelle était indispensable pour permettre aux générations futures de préserver la liberté qu’ils venaient de gagner au prix d’un grand péril et de grandes souffrances.

Telles sont les généralités et les lignes directrices qui doivent circonscrire la recherche que nous allons entreprendre pour une définition adéquate du véritable sens commun. Nous devons d’abord nous pencher sur la question de la survie réussie d’une société dans son ensemble. C’est dans ce cadre de référence que nous devrons définir cette qualité essentielle de l’individu sans laquelle la société dans son ensemble ne pourrait pas survivre.

Survie réussie

Un nageur a été sauvé de la noyade juste avant que ses forces ne l’abandonnent. Voilà ce qu’est la survie momentanée. Est-ce un paradigme pour la survie réussie de toute une société ? Comment devons-nous faire la distinction entre survie momentanée et survie durable ?

Ce qui précède engendre, à présent, ce qui suit.

Sélectionnons un moment d’un processus continu de survie d’une société dans son ensemble. Ce processus est l’agrégation et l’interaction des décès, des arrivées à l’âge adulte, des naissances et des conceptions qui, pris ensemble, définissent une collection d’individus fonctionnant comme un tout indivisible.

Ce moment servira comme instant de départ pour un voyage continu vers le futur. Appelons « A » ce moment. Appelons B, C, D, etc., les termes de la série de chacun des moments ultérieurs sélectionnés dans ce voyage.

La survie du nageur à l’instant B augure-t-elle de la probabilité de sa survie continue à travers les étapes C, D, etc. ? Peut-être permet-elle une postérité réussie ? C’est ici que se trouve la différence sommaire entre survie momentanée et survie réussie.

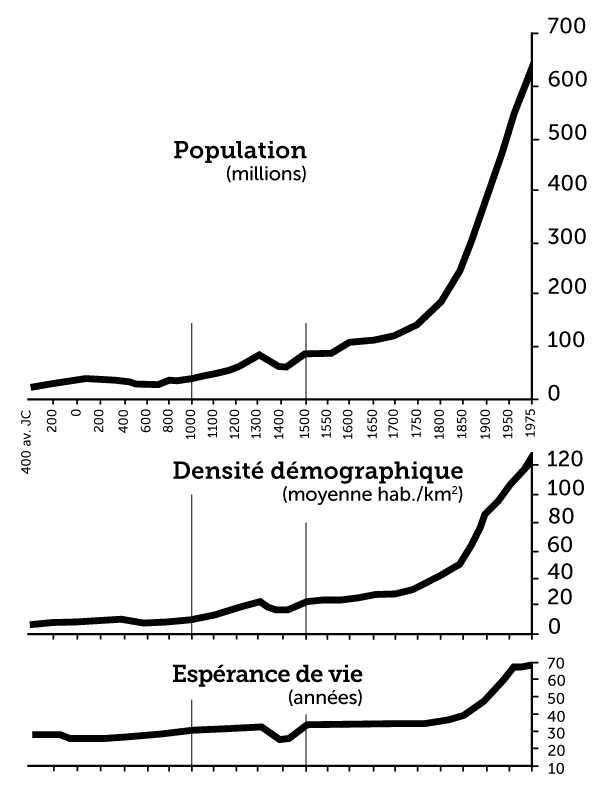

Considérons ce voyage vers le futur comme s’il s’agissait d’une sorte de fonction continue de physique mathématique. C’est de manière continue que la cause engendre l’effet et que l’effet a une relation de causalité avec les effets suivants. Cette fonction s’exprime en termes d’augmentation, ou de diminution, d’une grandeur appelée potentiel de densité démographique.

Il ne s’agit pas d’un type de fonction ordinaire ou « linéaire » ; elle est « non linéaire » mais elle est néanmoins une fonction continue efficiente en termes expérimentaux de référence. Nous approfondirons ce point en temps utile, après avoir examiné les notions de densité démographique et de potentiel de densité démographique.

Densité démographique est prise ici dans son sens habituel. Elle correspond assez grossièrement au nombre moyen de personnes habitant sur un kilomètre carré de territoire. A y regarder de près, ce rapport s’avère bien plus intéressant qu’il ne semble à première vue.

Certains anthropologues nous enseignent qu’il était une fois, alors que la Terre était encore une utopie sauvage, l’humanité vivant dans un état d’innocence infantile en harmonie avec la nature, état appelé « société simple de chasse et de cueillette ». Il ne reste plus de preuve permettant d’affirmer qu’une telle société primitive ait pu exister, bien que l’on connaisse de nombreux cas de sociétés défaillantes qui se sont effondrées dans des états ressemblant à cette utopie.

Au-delà de notre simple obligation de noter l’existence de ces faits, il n’est pas pertinent ici de savoir si de tels états de société ne sont que les derniers degrés d’un processus de régression d’une culture ou s’ils peuvent également exister en tant que moments dans le développement d’une société en croissance. Pour un tel état de société, les caractéristiques démographiques et économiques qui lui sont attachées sont connues avec un assez bon degré d’estimation.

On estime que la densité démographique y est d’une personne par dix kilomètres carrés de territoire sauvage. En d’autres termes, la société utopique « de chasse et de cueillette » ressemble à une « tribu » de babouins ou de « Yahoos » (en référence aux Yahoos rencontrés par Gulliver lors de son voyage chez les Houyhnhnms. Jonathan Swift, Les Voyages de Gulliver, traduction de Jacques Pons, Gallimard, 1984). L’espérance de vie après l’enfance y est, de manière significative, inférieure à une moyenne de vingt ans. On estime que la limite supérieure de la population d’une telle utopie est environ de 10 millions de personnes pour toute la surface de la Terre.

La population humaine actuelle est cependant supérieure à 5 milliards de personnes. Si l’humanité dans son ensemble avait mis en œuvre les niveaux de technologie déjà disponibles en 1970, et cela à un degré où elle pouvait le faire, non seulement cette population serait bien plus grande aujourd’hui mais, de plus, le niveau de vie par tête serait voisin de celui de l’Amérique du nord de 1970, et la population potentielle (à ne pas confondre avec la population réelle) serait de l’ordre de 25 milliards de personnes.

L’augmentation simultanée des densités démographiques réelle et potentielle au cours des derniers millénaires est le résultat de processus continus et interdépendants de génération, de transmission et d’assimilation efficiente de progrès scientifiques et technologiques.

Cela signifie que la transformation du territoire et des pouvoirs productifs du travail, qui reflète directement l’impact causal du progrès scientifique en tant que tel, présente les qualités suivantes d’impact sur la densité démographique potentielle :

- La fertilité du territoire, en matière de production et d’habitations pour la population, est augmentée.

- La productivité physique du travail est augmentée.

- Le niveau de vie des ménages par tête (panier de la ménagère) est amélioré.

La quantité de territoire nécessaire pour faire vivre en moyenne une personne diminue, alors que les niveaux de consommation physique requis et réalisés augmentent.

Nous découvrons également que les changements suivants se produisent avec l’augmentation de la productivité physique potentielle du travail et l’augmentation du besoin de consommation par tête qui l’accompagne : - La quantité d’énergie consommée par tête et par hectare augmente.

- La quantité d’énergie concentrée sur un secteur du domaine de travail tend à être augmentée.

Les changements sociaux suivants sont également corrélés aux augmentations de la productivité physique : - Le rapport de la population urbaine à la population rurale augmente vers ce qui semble être une limite asymptotique supérieure.

- Le rapport du travail utilisé dans la production de biens d’équipement, au travail utilisé dans la production de biens de consommation, augmente.

Ces changements se produisent sous réserve que la production, par hectare et par tête, des biens du secteur rural et des biens de consommation augmente et ne diminue jamais. Ces préconditions sont associées à d’autres changements démographiques : - L’âge de maturité (c’est-à-dire l’âge d’arrivée sur le marché du travail) augmente vers ce qui semble être une limite asymptotique.

- Il y a une tendance générale à une mutation des travailleurs engagés dans la production physique qui passent de types d’emploi à main-d’œuvre intensive à des types d’emploi à forte densité capitalistique.

Une survie réussie signifie que toutes ces préconditions soient satisfaites. Ces préconditions déterminent le lien de causalité entre les progrès technologiques et les augmentations du potentiel de densité démographique.

Considérons la série A, B, C, D, ... , Z, sous cet éclairage. Assignons à chacun de ces termes un moment spécifique du développement de l’humanité, ainsi qu’une estimation appropriée du potentiel de densité démographique.

Pour consoler les anthropologues qui nous lisent, assignons à « A » un temps – il était une fois dans la préhistoire imaginaire – où l’on trouverait son utopie de « simple chasse et cueillette ». Plus tardivement dans la série, on trouve des moments de la véritable histoire de véritables sociétés, comme Athènes en 479 av. J.-C., l’Europe occidentale au moment du recensement de Charlemagne, l’Italie en 1439, l’Angleterre en 1588, la France en 1672, la France en 1776, les Etats-Unis en 1866, les Etats-Unis en 1946, etc. Chacun des termes de cette série représente, pour l’humanité dans son ensemble, une valeur relativement plus élevée du potentiel implicite de densité démographique que celle de tous les termes précédents.

La question qui se pose de façon implicite est la suivante : tout progrès du potentiel en B est-il la cause des progrès ultérieurs se produisant en C, D, etc. ? S’il y a une certaine nécessité causale reliant l’apparition d’un potentiel relativement plus élevé au moment M, au potentiel encore plus grand au moment suivant N, et si cela est également vrai des relations causales entre N et le moment suivant O, entre O et P, P et Q, etc., alors l’augmentation du potentiel en M est une cause implicite des augmentations en N, O, P, Q, etc.

Il s’agit d’une approche sommaire d’un paradigme pour la survie réussie de toute une société.

Ce n’est pas une sorte de fonction algébrique ordinaire. Nous allons maintenant procéder à une première exploration pertinente de l’esprit de l’individu humain et trouver une preuve de la raison pour laquelle seuls des nombres géométriques non algébriques peuvent nous donner un reflet du potentiel de densité démographique tel que nous l’avons exposé jusqu’ici.

Le potentiel de densité démographique

Jusqu’au début des années 70, pratiquement aucune personne saine d’esprit et instruite selon notre tradition culturelle européenne occidentale n’aurait eu besoin de l’explication qui précède sur la corrélation causale entre le progrès scientifique et technologique, en tant que cause immédiate, et l’augmentation du potentiel de densité démographique momentané, en tant qu’effet.

Nous ne pouvons pas en rester là. La manière dont nous avons défini le potentiel de densité démographique, non pas simplement en tant que survie momentanée mais en tant que survie réussie, remet tout en question.

Avant de définir la fonction pour une survie réussie, nous devons examiner deux sujets annexes. Le premier est la signification profonde du progrès scientifique et technologique. Après cela, nous nous intéresserons au fait que toute véritable loi naturelle doit être cohérente avec la caractéristique centrale des fonctions géométriques non algébriques : l’isochronie.

En ce qui concerne le progrès technologique, c’est un simple fait qu’aucune espèce animale ne peut présenter un tel comportement. Le progrès scientifique et technologique reflète une qualité de l’individu humain qui place l’humanité à part et au-dessus de toutes les autres créatures vivantes. Chez les animaux, le type de changement de comportement que l’espèce peut générer d’elle-même pour son propre profit est délimité, pour ainsi dire, par un instinct fixe. En conséquence, le potentiel de densité démographique de l’espèce peut être changé localement, ou globalement, par des changements introduits dans l’environnement de l’animal, mais celui-ci ne peut pas augmenter volontairement ce potentiel de manière significative.

Du fait que nous examinons cette qualité unique du comportement de l’espèce humaine du point de vue d’une fonction continue de physique mathématique, il semble approprié que nous définissions le progrès scientifique comme une classe d’événements mathématiques. C’est lorsque l’on décide de faire cela que l’on commence à s’amuser.

Aucun système mathématique formel, c’est-à-dire aucune mathématique basée sur la logique déductive, ne peut représenter le plus élémentaire acte de découverte scientifique. Ainsi, la logique déductive est inutile pour représenter la vie mentale de l’être humain ; cependant, en montrant ce que la logique déductive ne peut pas faire, nous comprendrons plus clairement ce qui se passe dans tout véritable acte créateur scientifique, ou analogue, de l’esprit humain.

A première vue, la densité démographique est un simple rapport : celui du nombre calculable de personnes sur le nombre calculable de kilomètres carrés de territoire qu’elles habitent. On peut l’admirer comme un moyen de représenter certaines idées très utiles concernant la survie momentanée, à l’instant B ; mais il est inutile en tant que terme, lorsque l’on s’intéresse à la survie réussie, c’est-à-dire les valeurs imputées de chacun des instants B, C, D, etc., au moment B.

A titre d’exemple, on peut citer le système d’inéquations linéaires de John von Neumann qui semble s’appliquer avec succès pour estimer les potentiels de densité démographique d’écologies animales ; ces méthodes mathématiques sont pires qu’inutiles dans le cas d’ « écologies » humaines.

La difficulté suprême dans ces deux cas réside dans le comportement mental de l’être humain : le rôle du progrès scientifique et technologique, en tant que principe causal, pour générer l’augmentation du potentiel de densité démographique comme effet. Une orientation de progrès scientifique et technologique entraîne assurément une tendance à augmenter son potentiel de densité démographique. Nous allons examiner l’élaboration d’une représentation intelligible de cette fonction continue.

Cette fonction, dont nous cherchons ici les grandes lignes de construction, est caractéristique de l’ensemble du comportement humain qui est lié à une survie réussie. Elle ne convient pour aucun type de comportement animal.

La forme générale de cette fonction est donnée de la manière suivante :

- Le progrès technologique favorise une augmentation du potentiel de densité démographique.

- L’augmentation de potentiel de densité démographique qui en résulte favorise les conditions pour faire progresser le niveau technologique des activités courantes.

- Cela, s’il est réalisé, favorise à son tour une augmentation du potentiel de densité démographique.

Ce qui précède suppose que soient remplies les préconditions corrélées spécifiées plus haut.

Dans les cas où une telle fonction est continue en effet, la direction de progrès scientifique et technologique contenue dans une impulsion exercée sur l’intervalle entre A et B va définir une « trajectoire » de progrès successifs dans la technologie et dans le potentiel de densité démographique. Cette « trajectoire » représente une fonction mathématique continue en termes de taux d’accroissement du taux d’accroissement du potentiel de densité démographique. Ainsi, une valeur de cette fonction au moment B exprime aussi une valeur imputée pour les instants C, D, etc.

Elaborons maintenant une représentation intelligible de cette fonction continue. Nous allons le faire en réfutant la thèse principale des Critiques d’Emmanuel Kant.

Ce que nous allons réfuter, c’est l’erreur de Kant en ce qui concerne la possibilité de donner une représentation intelligible de ces formes d’activité mentale créatrice exprimées par une découverte fondamentale valide en physique mathématique. Le théorème néo-aristotélicien de Kant présente le mérite relatif et pervers d’être le plus exhaustivement rigoureux parmi les représentants modernes de la même opinion sur le sujet, c’est-à-dire Francis Bacon, Hobbes, Galilée, Descartes, Locke, Hume, Laplace, Cauchy, Kelvin, Maxwell, Kronecker, Bertrand Russell, etc. En réfutant le dogme de Kant sur ce point, nous exposerons donc l’erreur et l’absurdité de tous les dogmes anti-platoniciens en général.

La caractéristique centrale du dogme fallacieux de Kant, ainsi que celui de son plus important prédécesseur sur ce point, Descartes, est une foi aveugle dans la logique déductive.

Comme nous allons le montrer maintenant, la logique déductive, la base de ce qui est enseigné aujourd’hui en mathématiques dans les écoles, ne permet pas d’élaborer une représentation intelligible d’une véritable fonction non linéaire ; ainsi, la logique déductive (ainsi que toute mathématique enfermée dans son formalisme) ne permet pas de comprendre les fonctions vraiment élémentaires de l’univers physique.

Kant a eu au moins le mérite relatif de reconnaître l’existence de découvertes fondamentales valides en physique. Cependant, tout en reconnaissant l’existence de ce phénomène, il reconnaissait aussi que le processus par lequel de telles découvertes sont engendrées dans l’esprit humain ne peut pas être, en tant que tel, sujet d’une représentation intelligible dans le cadre de la méthode déductive.

Selon la méthode déductive, les processus mentaux créateurs n’ont pas d’existence valide dans notre Univers. Le mieux que la déduction puisse faire est de reconnaître que de tels phénomènes existent. Résumons maintenant, d’un point de vue moderne, ce qui constitue le cœur de l’argument de Kant.

Tout système idéal de logique déductive commence avec un ensemble d’axiomes et de postulats.

Les axiomes sont des théorèmes adoptés sans preuve et sur la base de l’affirmation qu’ils sont vrais de façon « auto-évidente » [self-evident]. Les postulats sont des théorèmes adoptés sans autre preuve que l’indication suivant laquelle de telles suppositions doivent être ajoutées à l’ensemble d’axiomes afin d’éliminer arbitrairement toute ambiguïté dans le système dérivé d’un ensemble combiné d’axiomes et de postulats.

Un premier niveau de théorèmes est dérivé d’un ensemble initial d’axiomes et de postulats. Un second niveau de théorèmes est à son tour déduit de la combinaison du premier niveau de théorèmes et de l’ensemble d’axiomes et de postulats. C’est ainsi que se développe l’édifice des théorèmes, niveau par niveau, sur la fondation des axiomes et postulats initiaux.

Il en résulte ce que l’on appelle un réseau de théorèmes (déductif). Tout théorème possible dans ce « réseau » est déductivement consistant avec chacun des axiomes et postulats de l’ensemble sous-jacent. Le corollaire de cela est : aucun théorème d’un réseau de théorèmes déductif véritablement consistant n’affirme rien qui ne soit déjà implicite dans l’ensemble sous-jacent d’axiomes et de postulats. Cette « propriété » est connue sous le nom de « principe d’hérédité » de tous les réseaux de théorèmes déductifs consistants.

Dans un tel contexte, considérons les implications d’une simple expérience physique décisive valide qui viendrait contredire un seul théorème du corps d’un dogme de physique-mathématique.

Une forme déductivo-formelle de mathématique domine actuellement la physique mathématique et l’enseignement. Bien que dans la pratique, aucune branche enseignée de la physique mathématique ne soit consistante comme le « principe d’hérédité » déductif exigerait qu’elle le soit, l’intention implicite de l’enseignement et de la pratique de la physique mathématique formelle est qu’une telle consistance parfaite doit prévaloir. A ce jour, dans de telles conditions, l’enseignement de la physique mathématique est principalement, dans le moins pire des cas, kantienne.

Ainsi, cet ensemble de pratiques courantes est obligé de remplir tous les critères de preuve de consistance que l’on trouve implicitement dans la méthode déductive kantienne.

Si une seule expérience physique décisive montrait qu’un théorème quelconque, défendu avec véhémence par l’école de physique mathématique actuelle, est faux, cette preuve physique impliquerait, en vertu du « principe d’hérédité » déductif, que l’ensemble d’axiomes et de postulats, sur lequel repose toute cette physique mathématique, est erroné.

Dans la pratique, lorsque se présente une telle preuve expérimentale décisive, il ne faut pas immédiatement sauter à la conclusion que le principe d’hérédité s’applique d’une manière aussi dévastatrice. Aucun dogme de physique mathématique existant (en dehors peut-être de certains très obscurs et abstraits) n’est déductivement consistant. Cette inconsistance, comme elle concerne n’importe quel théorème connu, doit d’abord être examinée avant de conclure qu’il faut procéder à une révolution scientifique.

Supposons que nous ayons pris toutes les précautions nécessaires. Supposons, par conséquent, que nous disposions d’un fait établi, d’une expérience décisive contredisant au moins l’une des affirmations inscrites dans l’ensemble d’axiomes et de postulats sous-jacent. Dans ce cas, en se servant du « langage » des ordinateurs, la correction suivrait de façon implicite les étapes décrites ci-après :

- L’affirmation axiomatique mise en défaut est remplacée à l’aide d’une hypothèse adéquate.

- Le réseau de théorèmes existant est revu en totalité, pour ainsi dire théorème par théorème, afin de répercuter ce changement sur une « base héréditaire ».

- Chacun de ces théorèmes révisés est soumis à une expérience décisive appropriée, au moins implicitement.

- Si cela ne donne pas un résultat valide, une nouvelle hypothèse corrective est nécessaire, et le processus recommence.

- Si la reconstruction est réussie, en vertu du critère de l’expérience décisive, la « révolution scientifique » correspondante peut être considérée comme un succès.

Une telle « révolution scientifique » peut maintenant nous permettre de caractériser les types de transformations, comme celles de A vers B, qui sont liées à l’impact causal du progrès scientifique et technologique par rapport à l’augmentation de potentiel de densité démographique qui en résulte.

Définissons l’erreur de Kant du point de vue que nous venons d’ébaucher.

Considérons une série de telles transformations scientifiques et technologiques d’une société : A → B ; B → C ; C → D ; D → ... Définissons chacune de ces transformations « axiomatiquement » par une expérience cruciale comme on l’a vu ci-dessus. Dans cette représentation, A, B, C, D, etc., sont définis comme dans le cas hypothétique du nageur vu précédemment.

Accordez-moi la ruse suivante. Supposons que chacun des moments A, B, C, D, etc., corresponde à un ensemble spécifique d’axiomes et postulats déductivo-formels, tel qu’aucun ensemble associé à n’importe quel terme de cette série ne soit déductivement consistant avec l’ensemble associé à aucun autre des moments en question.

Cette ruse va nous faire tomber dans l’erreur mais cette erreur est notre objectif immédiat. Nous apprendrons plus en faisant l’expérience de cette erreur que si nous ne l’avions pas risquée.

Supposons que, dans chacun des cas, l’ensemble d’axiomes et de postulats se trouve dans une certaine forme de correspondance avec le niveau de « l’état de l’art » scientifique et technologique du moment en question. Formellement, ce niveau scientifique et technologique peut être, ou pas, représenté différemment que par le choix corrélé de l’ensemble d’axiomes et de postulats. On suppose seulement que l’ensemble choisi décrit autant que possible le niveau réel de l’état de l’art du point de vue des réseaux de théorèmes déductifs.

L’événement qui nous intéresse, c’est lorsque se produit une transformation décisive et expérimentale qui nous oblige à remplacer l’ensemble d’axiomes et de postulats α0 par α1, α1 par α2, etc. Nous prenons ici comme convention que A, B, C, D, etc., sont tels que A → B représente un intervalle au cours duquel α0 est implicitement remplacé par α1 etc. Donc A ≡ [l’ensemble] α0, B ≡ α1, C ≡ α2, etc.

L’événement qui devient le sujet élémentaire (la « variable ») de notre fonction historique continue, c’est le processus de transformation représenté par la flèche reliant chaque paire de termes successifs (les moments). Comparons alors α0 et α1. Cherchons, de cette manière, à définir la nature de l’événement dont dépend la notion de cette fonction continue.

Aucun théorème du réseau de théorèmes A n’est consistant avec aucun théorème du réseau de théorèmes B. Il n’y a pas de continuité déductive entre les deux réseaux. Ils sont séparés par un gouffre logique dont les bords ne peuvent être reliés par aucune méthode déductive.

Dans le langage de la mathématique formelle, celle que l’on enseigne habituellement dans les écoles, ce gouffre logique portera le nom d’une simple discontinuité mathématique.

Cette discontinuité est la substance (c’est-à-dire la « matière », la « substance matérielle » de cette action qui définit cette fonction continue dont nous sommes en train d’élaborer une représentation intelligible : le taux d’accroissement du potentiel de densité démographique. Du fait qu’elle est clef pour définir la survie réussie, cette fonction est indispensable pour élaborer ensuite une véritable définition du sens commun.

Transformation continue

Cette action est la transformation du réseau A en réseau B, et ainsi de suite. Nous sommes donc obligés de représenter le problème du point de vue de la théorie de réseaux déductifs. Toute découverte fondamentale validée par une expérience décisive, en science physique par exemple, sera de cette forme, dans la mesure où celle-ci doit être reconnue de ce point de vue déductif.

Cette action, même si elle n’est considérée que de manière abstraite, est en soi une qualité qui place l’humanité absolument en dehors et au-dessus du règne animal. Considérons, une fois encore, le processus de phase que l’on a pu dégager en termes de ces étapes :

- Le progrès scientifique et technologique, réalisé par la génération de la discontinuité décrite ci-dessus, est la cause d’une augmentation par tête du pouvoir de la société sur l’ensemble de la nature, effet qui s’exprime par un accroissement du potentiel de densité démographique.

- Ainsi, une activité mentale en tant que telle, la pensée créatrice, est une cause physique puissante d’un effet physique.

- La transformation de la connaissance et de l’activité, dont la cause est la transformation du potentiel de densité démographique due elle-même au progrès scientifique et technologique, est à son tour la condition d’une nouvelle vague de génération, transmission et assimilation efficiente de progrès scientifique et technologique.

- Cela génère implicitement, à son tour, un nouvel accroissement de potentiel de densité démographique.

Et ainsi de suite.

Si nous avions tracé cette séquence de causes et d’effets en nous arrêtant à la seconde étape, cela aurait signifié que le résultat du progrès scientifique et technologique se limitait à la survie momentanée. En poursuivant avec la troisième et la quatrième étape, nous décrivons un cycle complet dans lequel le résultat est mesuré en termes de concept de survie réussie.

A la différence de l’étendue relativement fixe de potentiel de densité démographique (relative) [5] de chaque espèce et variété animales, pour lesquelles l’étendue des variations possibles semble être fixée par « instinct », l’homme transforme l’« instinct » de son espèce à volonté. Bien que notre espèce ne puisse pas transformer son « instinct » de façon arbitraire, les sociétés peuvent réaliser de tels changements en suivant des chemins légitimes et en utilisant des moyens légitimes.

Ce que nous avons jusqu’à présent considéré à ce sujet nous montre qu’à n’importe quel moment A, nous pouvons choisir, implicitement, parmi un certain nombre de différents voyages vers le futur :

A0 → B1 → C1 → D1 →

↓ → B2 → C2 → D2 →

↓ → B3 → C3 → D3 →

↓ → ... … …

Et ainsi de suite. De même, n’importe quel des B, des C, des D, etc., dans ce tableau, de n’importe quel choix de série, peut devenir un nouveau point de départ, Ai, après lequel un choix quelconque parmi un certain nombre de Bi peut déterminer un nouvel embranchement, une nouvelle trajectoire vers le futur.

Cela signifie que nous considérons la transformation (A → B) comme relativement décisive, et que nous la considérons à la lumière de notre cycle en quatre étapes définissant implicitement une action de survie réussie. Le fait que la transformation (A → B) a comme effet de conditionner la cause de la transformation (B → C) est ce qui définit implicitement le caractère continu, donc la transformation continue que nous examinons ici.

De telles fonctions ne peuvent pas être comprises dans le cadre d’une physique mathématique qui serait consistante avec les principes d’une logique déductive. Résumons cette question au regard des faits que nous avons notés jusqu’à présent.

L’action qui exprime la transformation du réseau A en réseau B ne se situe que dans la discontinuité mathématique séparant absolument le domaine du réseau B du domaine déductif du réseau A. Cette discontinuité est la division qui définit le caractère discret de B par rapport à A. Cependant, cette action que constitue la transformation ne peut être représentée de façon intelligible par aucune forme de logique déductive.

Pour s’assurer que ce qui devrait être évident le soit véritablement, nous ajouterons ce qui suit. Pour être compris dans un schéma déductif quelconque, le sujet en question doit être défini sous la forme d’un théorème consistant dans un réseau de théorèmes déductif. Or, par définition – par construction – il n’existe aucun réseau de théorèmes déductif qui puisse subsumer la discontinuité en tant que proposition de théorème consistante, sauf pour affirmer, comme Kant l’a fait, l’incompréhensibilité de la discontinuité dans un cadre déductif.

Le sujet principal des Critiques de Kant se résume à affirmer que les processus créateurs qui génèrent des découvertes fondamentales valides en science physique sont intrinsèquement incompréhensibles en tant que processus. Il montre que cela est vrai pour toute analyse déductive et nie la possibilité d’élaborer toutes autres représentations intelligibles que la déduction.

A cet effet, il démarre son argument en concédant le fait que la découverte créatrice existe. Il reconnaît que de telles découvertes dans les sciences physiques sont des faits rationnellement compréhensibles, mais seulement après qu’elles se soient produites – a posteriori. Ainsi, il aurait concédé a posteriori que le réseau B est le successeur du réseau A. Il se serait forcé à reconnaître que B est analytiquement distinct de A. De même, il se serait forcé à reconnaître que, du point de vue de la théorie de réseaux déductifs, B est partout inconsistant déductivement avec A.

De la même manière, la méthode kantienne est obligée de reconnaître l’existence d’une discontinuité en tant que caractéristique de cette transformation qui génère B à partir de A. Cependant, bien que la méthode de Kant puisse reconnaître l’existence de la discontinuité en tant que telle, elle ne peut la reconnaître que comme un abîme sans fond dans l’étendue de l’espace logico-déductif, un gouffre dont les bords ne peuvent être reliés mais seulement franchis d’un bond, par intuition, si toutefois il se trouve quelqu’un capable de le faire. La méthode kantienne ne peut pas élaborer une représentation intelligible de cet abîme apparent.

Considérons cette question dans un autre cadre de référence.

Au mieux, l’analyse déductive peut reconnaître l’existence de la discontinuité en tant que forme mais non en tant que substance. Elle peut reconnaître l’existence de la discontinuité dans le sens où l’on reconnaît une ligne de longueur indéfinie séparant deux aires générales d’une surface plane, ou une surface enveloppant un volume d’espace, empêchant ainsi l’espace intérieur de trouver une continuité avec le volume de l’espace extérieur. Dans la mesure où la déduction limite la notion de « matière » à des particules discrètes (des singularités délimitées) dans un espace vide et un temps vide, elle ne peut pas tolérer que l’on attribue les qualités de matière, mis à part le caractère discret lui-même (la forme), à une discontinuité.

Axiomatiquement, l’analyse reconnaît les points, les lignes, les surfaces, les solides et les hypersolides comme des singularités, et reconnaît que la discontinuité est une propriété essentielle de la singularité. Cependant, axiomatiquement, la pondérabilité n’est pas permise pour le point, la ligne ou la surface elle-même, etc.

Toutefois, comme nous l’avons indiqué, la singularité exprimée par la discontinuité de (A → B) est l’action efficiente au moyen de laquelle le réseau A est transformé en réseau B. Cette transformation, ainsi décrite, n’est autre que l’expression déductive de l’action du progrès scientifique et technologique. L’effet de cette action, en tant que cause, est une augmentation du potentiel de densité démographique de la société. Laquelle est un effet très pondérable ; le progrès scientifique et technologique est une « force » très pondérable ; la transformation qui engendre la force du progrès, est une « force » physiquement efficiente.

Partant de là, tout ce qui suit dépend de notre compréhension du type de discontinuité mathématique que nous avons identifié. Nous devons résoudre, étape par étape, les questions difficiles concernant la nature de son existence, et la possibilité d’une représentation intelligible de cette existence.

On pourrait penser que la discontinuité suggère quelque chose qui n’a pas d’existence, dans le sens où l’on pense habituellement la notion d’existence.

Par exemple, l’idée que deux objets diffèrent n’est pas en soi une existence. De même, l’idée simple selon laquelle un objet fini cesse de s’étendre au-delà de ses limites extérieures n’est pas non plus une existence distincte. Attribuer une existence à de tels objets serait du même ordre que de dire : « J’emmène avec moi ma non-femme pour une promenade, afin de me promener tout seul » ; de telles phrases ont beaucoup de sens pour un véritable logicien mais pas pour une personne ayant un véritable sens commun.

Cependant, si une limite a une forme distincte, cette forme représente un certain type d’existence pour cette limite. Cette forme peut être négative, dans le sens d’une délimitation imposée de l’extérieur, ou positive, dans le sens d’une limite auto générée.

Considérons maintenant la notion d’existence matérielle. Il serait absurde d’attribuer la qualité de matière à n’importe quelle propriété exprimée autre qu’un agent causal efficient. Cela suggère, du fait que la discontinuité est la cause de la transformation du réseau A en réseau B, que la discontinuité est un agent efficient et, en conséquence, matériel.

Avant de pouvoir exploiter ces observations concernant l’existence, nous devons aborder une seconde strate de questions.

En faisant ici référence à une forme distincte, nous soulevons un problème : comment définissons-nous cette forme en tant que « distincte » ? Nos idées sur les « formes distinctes » conduisent à deux sous-classes. La première sous-classe est celle des formes que nous pouvons reproduire par l’usage d’un principe cohérent de construction. Cette construction d’une forme observée est une représentation intelligible de cette forme. Le caractère distinct démontré au moyen d’une telle représentation intelligible génère une sous-classe générale des formes distinctes.

La seconde sous-classe de formes distinctes comprend ces exemples qui semblent défier toute forme adéquate de représentation intelligible de ce type. Bernhard Riemann parle de telles formes comme exprimant une fonction arbitraire [6].

Néanmoins, les formes de la deuxième classe sont implicitement compréhensibles. Si nous tentons de les reproduire par construction, nous créons des représentations intelligibles que l’on peut qualifier de « in extremis ». La différence entre de telles représentations « in extremis » et la « courbe » apparemment arbitraire peut être quantifiée par un nombre distinct de singularités (discontinuités) pour chacune des classes considérées. Cette nouvelle sorte d’intelligibilité de marges de différence constitue un type particulier de représentation intelligible, suffisant pour faciliter la reconnaissance.

Si nous trouvons dans l’Univers, hors de nos propres conjectures, la forme apparemment arbitraire, nous pouvons être certains que, tôt ou tard, une représentation intelligible sera construite.

Le second aspect concernant l’existence est que l’on associe substance à « matière ». C’est la question de la substantialité hypothétique des discontinuités (singularités) dans les fonctions de transformation implicites dans (A → B), (B → C), etc., qui concerne au plus haut point la définition stricte de la survie réussie et, par là, du véritable sens commun. Intéressons-nous maintenant à la question de substantialité.

Action circulaire et maximum-minimum

A ce stade, nous devons prendre un détour. A partir du moment où nous soutenons, comme nous allons le faire, que le rôle du progrès scientifique et technologique, en tant que cause efficiente, définit la fonction de transformation (A → B) comme existante aussi bien en tant que forme que substance, nous nous exposons à déclencher hurlements, jappements et grognements dans les chenils du formalisme déductif. Cela nous oblige à aborder brièvement un chapitre de l’histoire géométrique de la physique mathématique moderne.

Voici donc ce qui motive spécifiquement ce détour.

Pour être qualifiée non seulement d’existence formelle mais aussi d’existence ontologique, une singularité doit satisfaire à certaines conditions élémentaires. Tout d’abord, son existence doit être une cause efficiente d’un changement d’état dans un processus physique.

Considérons l’aspect le plus simple de notre ébauche de fonction pour l’augmentation du potentiel de densité démographique, la transformation élémentaire locale T(A → B) pour laquelle :

- T : désigne arbitrairement une fonction de transformation, implicitement une fonction continue d’un certain type.

- A : représente le taux d’accroissement du potentiel de densité démographique sur lequel s’exerce la transformation.

- → : représente la transformation.

- B : représente le taux d’accroissement du potentiel de densité démographique réalisé par la transformation de A.

→ est représentée, du point de vue formel (déductif), comme une discontinuité mathématique (logique) et que nous allons désormais qualifier principalement par un terme plus général que discontinuité : singularité. Cette singularité (→) est la cause efficiente de la transformation du taux d’accroissement du potentiel de densité démographique B - A.

Jusque-là, ça va. Enfin, ça semble être le cas, jusqu’à ce que nous allions au-delà de ce que nous avons dit concernant ce contexte immédiat. A partir du moment où nous voulons être cohérent avec ce qui précède au sujet de la substantialité inhérente de notre singularité, nous devons implicitement rejeter les représentations de matière, d’espace et de temps conçues par Galilée, Descartes, Newton, etc., pour les remplacer par la notion d’espace-temps physique de Kepler, Leibniz et Riemann.

Du point de vue de la géométrie euclidienne ou de l’arithmétique déductive (de Kronecker) présente dans les manuels scolaires, la correction semble être impossible. Nous sommes obligés de considérer une géométrie différente, une géométrie dite constructive ou véritable géométrie non euclidienne. Afin de réorganiser les éléments en vue d’un examen critique, considérons le bref historique qui suit.

La période de l’histoire de l’Europe depuis la mort de l’empereur Frédéric II en 1250 jusqu’au début de la Grande Peste noire représente, en un siècle, le plus brutal effondrement vers un âge des ténèbres de toute l’histoire connue de ce continent. La population a été réduite de moitié, et les niveaux de productivité ainsi que les niveaux culturels et moraux ont atteint des profondeurs épouvantables en comparaison à la première moitié du XIIIe siècle.

L’héritage augustinien, que l’on retrouve ancré dans le projet de Dante Alighieri, a conduit à la recréation de l’Eglise chrétienne et à la vie laïque puis à la Renaissance du XVe siècle. C’est à cette Renaissance que nous devons l’établissement et les premiers développements fructueux de la science physique moderne.

Bien que Brunelleschi, Toscanelli, Alberti, Léonard de Vinci et d’autres aient fait des contributions indispensables à différents niveaux, c’est l’apport fondamental du cardinal Nicolas de Cues, avec notamment sa De Docta Ignorantia (Nicolas de Cusa, De la docte ignorance, Ed. de la Maisnie, 1979), qui a rendu possible l’existence d’une physique mathématique complète.

Lors des deux premiers siècles pendant lesquels émergeait la physique mathématique, la méthode déductive n’a pratiquement joué aucun rôle. L’élaboration d’une physique mathématique complète a presque été achevée par Johannes Kepler, avant que ne soit connu le premier déductionniste notable : Galilée. Des déductionnistes tels que Galilée, Descartes, Newton et Boyle n’ont presque rien apporté de valable qui n’ait déjà été réalisé, en mieux, par des savants tels que Kepler, Gilbert, Desargues, Fermat, Pascal, Huygens et Leibniz.

C’est ainsi que Newton a produit une pseudo version incompétente de calcul infinitésimal environ onze ans après que Leibniz ait présenté le premier exposé détaillé d’un calcul différentiel à son imprimeur de Paris (1676). C’est ainsi que la gravitation de Newton n’a été qu’une pâle copie de la découverte antécédente de Kepler, réécrivant la formulation de Kepler à sa manière. Son travail ne vaut rien, tout comme celui de Francis Bacon.

La découverte capitale du Cusain fut celle du principe « maximum-minimum », duquel découlent par exemple le principe isopérimétrique de la topologie ainsi que le principe de moindre action de Leibniz. Ce principe « maximum-minimum » a libéré la géométrie et la physique de tout axiome et postulat ainsi que de la méthode déductive. C’est la seule définition exprimant une géométrie non euclidienne.

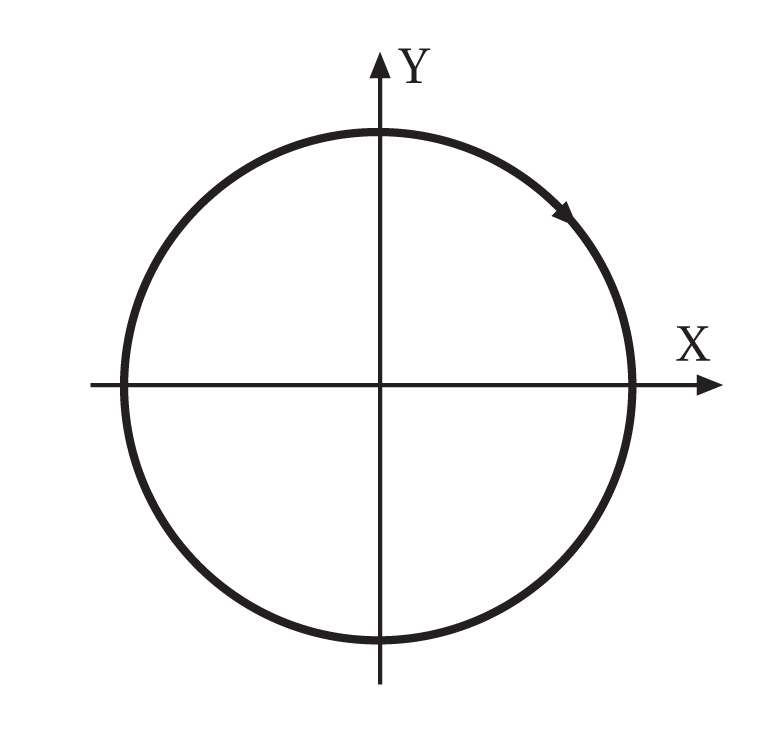

Ce principe maximum-minimum, appliqué à la question de cause et d’effet, correspond par exemple, à l’action minimale (périmétrique) générant l’aire (ou le volume) maximale relative en tant que travail accompli (généré) par cette action. Plutôt que de dire : « Cela revient à montrer que le cercle est la seule forme auto évidente en topologie », contentons-nous de dire que l’action circulaire exprime l’action minimale et que l’aire circulaire exprime (positivement) le travail maximal. Le cercle a cependant une signification particulière. Celle-ci ne fait pas intervenir des idées euclidiennes ou quasi euclidiennes mais seulement des idées topologiques. Le cercle est la base permettant d’introduire la notion de quantité dans l’espace-temps physique. La période d’un cycle de l’action minimale générant le travail effectué est la première étape vers la quantification de l’espace-temps physique.

Nous devons également relier ces quelques points au potentiel de densité démographique.

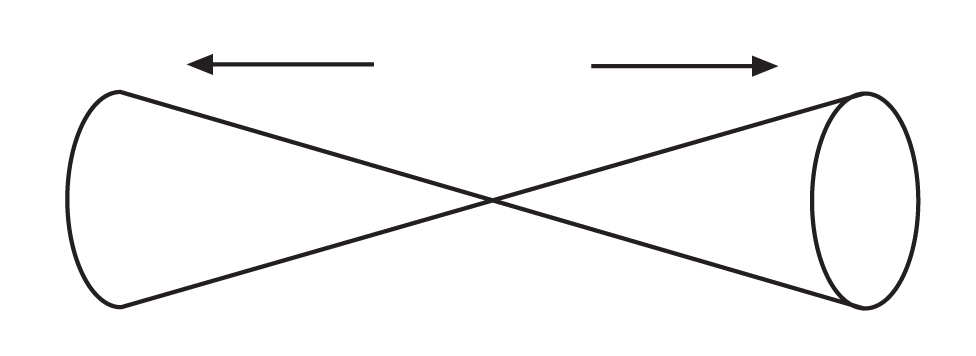

Si l’« action circulaire » est la seule action élémentaire évidente en soi dans l’espace-temps physique, alors l’action relève de la forme de l’action circulaire agissant réciproquement sur l’action circulaire dans tout intervalle arbitrairement petit de chaque action : c’est l’action circulaire multiplement connexe.

Ainsi, une représentation intelligible de la ligne droite est la génération de son existence par une action circulaire multiplement connexe. Il en est de même pour un point. Les points et les lignes droites ont donc des représentations intelligibles construites de leur existence ; aucun des deux n’a d’existence axiomatique « auto-évidente ».

Tous les axiomes et postulats euclidiens disparaissent de cette manière, et avec eux la synthèse déductive. Seule subsiste la construction réalisée selon le principe « maximum-minimum ».

L’interprétation de l’Univers physique dans sa totalité peut être accomplie implicitement à partir de « rien d’autre » que la preuve du principe « maximum-minimum ». Cela n’a jamais été – et bien entendu ne sera jamais – achevé par l’humanité mortelle. De plus, tout ce que l’homme élabore ainsi, dans la mesure où cela approche ce but inaccessible, constitue une représentation intelligible de cet Univers décrit de manière incomplète. Voilà implicitement la tâche et la nature de la véritable science physique ; voilà les limitations de ce qui peut être accompli.

Nous nous contenterons pour l’instant de souligner quelques caractères saillants. Nous les présentons comme des étapes successives pour affiner notre approche.

Imaginons que nous ne partons de rien d’autre que de l’« action circulaire » telle que le principe maximum-minimum définit cette action. Aucune forme d’existence « auto-évidente » n’est supposée, que ce soit sous couvert d’axiomes ou de postulats, ou d’une quelconque autre manière. De même, toute existence axiomatique d’un système de dénombrement est prohibée ; l’existence de nombres et de théorie arithmétique ne doit être dérivée que par construction géométrique, par aucun autre moyen direct ou annexe.

A partir de l’« action circulaire multiplement connexe », nous générons l’existence de « points » et de « lignes droites ». Poursuivant à partir de là, toutes les formes associées à la géométrie euclidienne sont construites comme représentations intelligibles, sans tolérer d’axiomes, de postulats, de méthodes déductives ou quelque autre moyen que ce soit, mis à part un principe de construction en accord avec le principe maximum-minimum de Nicolas de Cues.

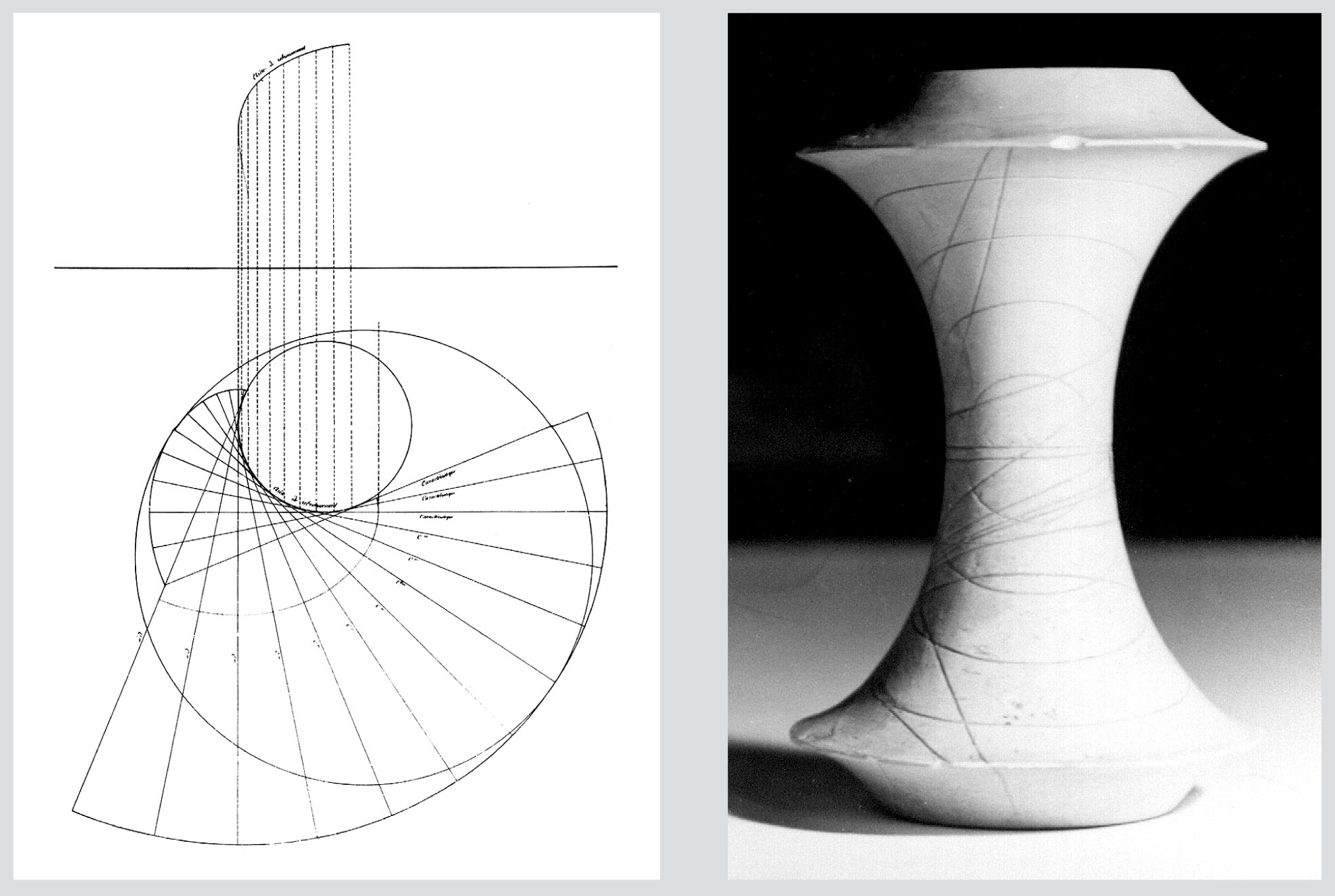

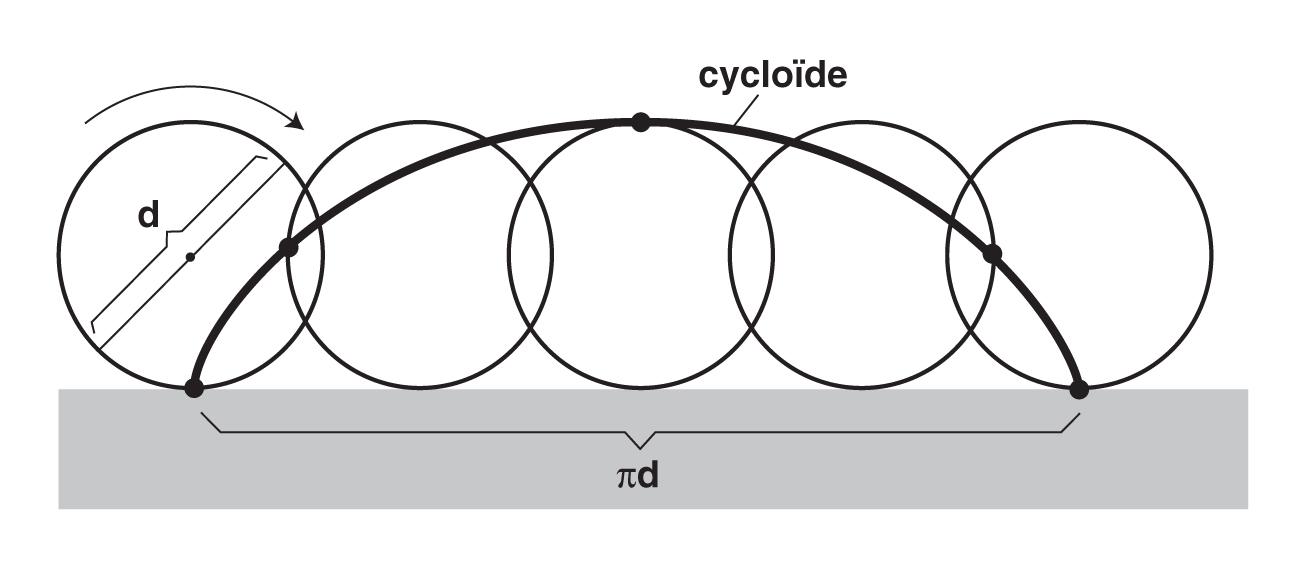

Nous pouvons également construire une seconde classe d’existences objectives, les cycloïdes, la courbure négative générée par l’action circulaire appliquée sur des objets tels que des lignes droites et des sections coniques. Ces cycloïdes, et leur relation au système de développées et de développantes, définissent ce que l’on appelle les fonctions non algébriques, dont le principe déterminant des véritables lois physiques, l’isochronie, est un exemple.

Il faut préciser que nous sommes ici en présence d’une autre sorte de « principe d’hérédité » que celle qui est caractéristique des réseaux de théorèmes déductifs. Ici, le « principe d’hérédité » est le principe de maximum-minimum du Cusain, exprimé comme un pur principe de construction géométrique-physique.

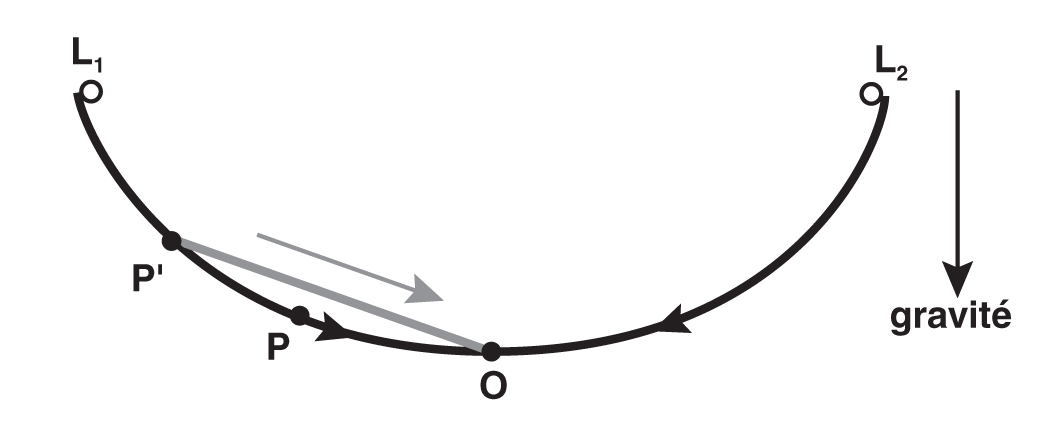

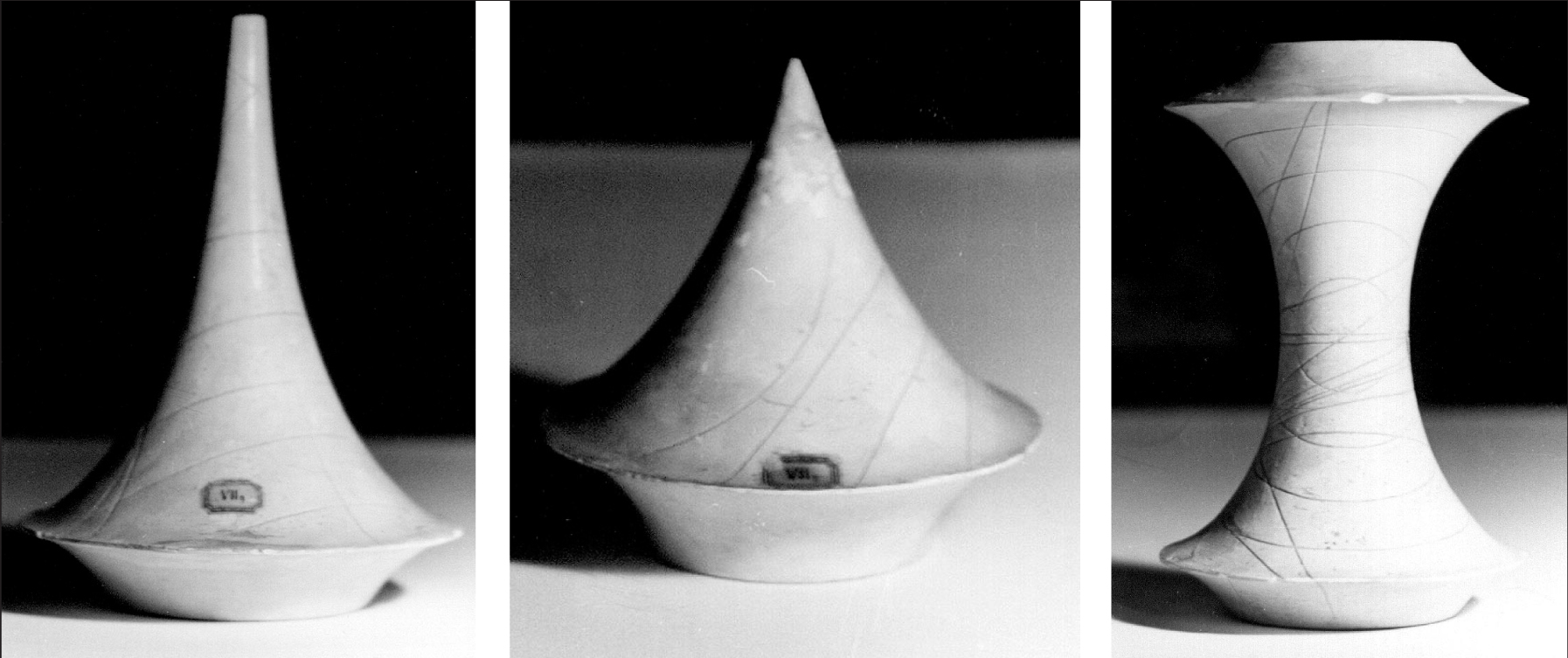

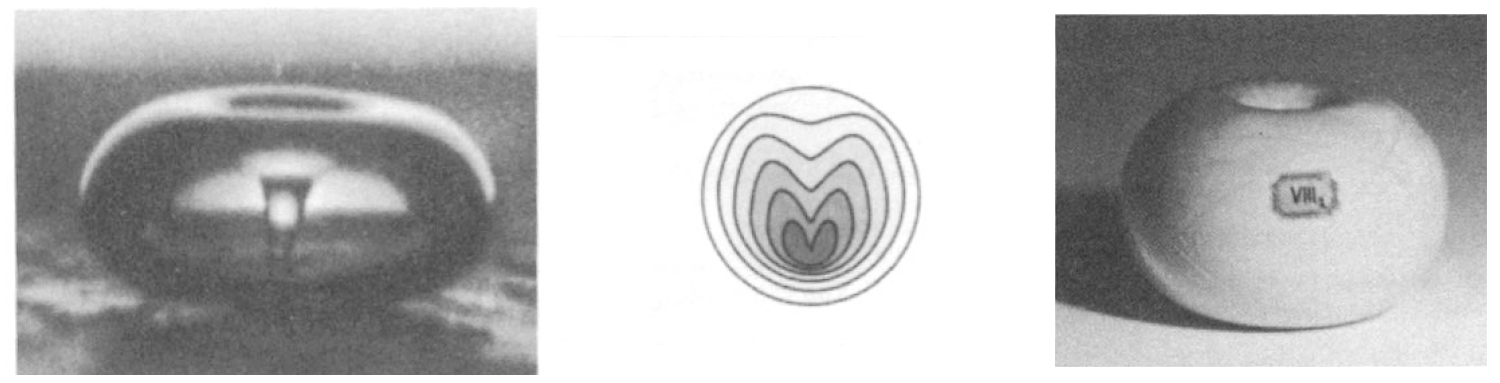

La phase suivante d’élaboration d’une géométrie physique est l’élaboration de l’action circulaire en tant qu’action spirale auto similaire (FIGURES 1, 2, 3 et 4). Cette généralisation, l’action spirale auto similaire, devient intéressante à partir du moment où l’on prend en compte le fait qu’en matière d’espace-temps physique, on a affaire à l’action spirale auto similaire multiplement connexe.

L’action spirale auto similaire multiplement connexe a comme particularité pertinente de générer des discontinuités mathématiques (des singularités). Il s’agit de la caractéristique du domaine complexe de Gauss-Riemann, dont la représentation intelligible est sa construction, au moyen de l’action spirale auto similaire multiplement connexe, selon le principe maximum-minimum de géométrie constructive.

Cela nous conduit directement à la question ontologique cruciale qui nous intéresse : l’efficience physique de la singularité comme caractéristique de la transformation (A → B).

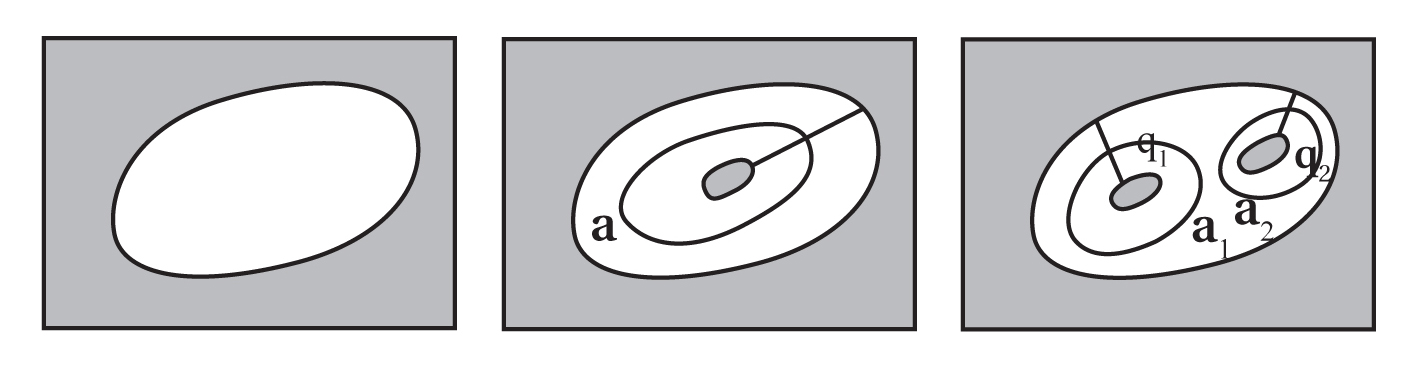

Toute une classe de fonctions continues non linéaires, pour lesquelles il est impossible de fournir une représentation intelligible avec moins de moyens, peut être représentée du point de vue du domaine complexe de Gauss-Riemann compris comme une expression de la géométrie synthétique non euclidienne [7].

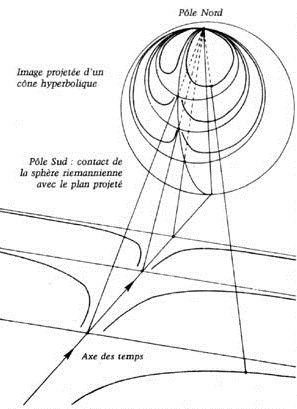

Cette solution peut être caractérisée, avec certaines limitations, par la fonction riemannienne de surface. Ainsi, de telles fonctions continues non linéaires peuvent être représentées de manière intelligible en tant que fonctions continues (FIGURE 5).

La question que nous venons de présenter de manière très sommaire nous conduit à un point déterminant. L’idée qui domine dans les écoles, selon laquelle la science moderne commence avec Francis Bacon, Galilée, Descartes et Newton, est une idée fausse. De plus, lorsque certaines contributions de Léonard de Vinci, Kepler, Gilbert, Huygens, Leibniz, Gauss ou Riemann sont malgré tout admises, ce n’est que d’un point de vue déductif. Ainsi, les cours de mathématiques répandent l’erreur selon laquelle la mathématique du formalisme déductif serait le seul langage de la physique mathématique.

Ici encore, nous devons insister sur le fait que la littérature de la science physique moderne se divise en deux camps. Le premier camp, qui a fondé la science physique moderne avec comme point de référence Platon et Archimède, est l’école de Nicolas de Cues, Léonard de Vinci, Kepler, Leibniz, Monge, Gauss et Riemann, reposant sur le « principe d’hérédité » de la géométrie physique synthétique. Le second camp, qui a envahi le domaine de la science physique depuis le XVIIe siècle, soit environ deux siècles plus tard, repose sur le « principe d’hérédité » des réseaux de théorèmes déductifs.

Bien que la littérature des deux camps semble souvent coïncider, un examen plus approfondi met en évidence un gouffre infranchissable entre les deux. Nous allons maintenant en examiner les conséquences.

Entropie et néguentropie*

[* L’auteur utilise aujourd’hui plutôt le terme d’« anti-entropie », NdT.]

Nous avons examiné plus haut certaines caractéristiques des séries, respectivement inconsistantes, de réseaux de théorèmes déductifs, désignées par leurs moments associés A, B, C, D, etc. Nous avons qualifié ces réseaux de théorèmes déductifs de discrets (finis), en vertu du fait que chacun d’entre eux est délimité, par rapport aux précédents et aux suivants, par un obstacle que l’on ne peut déductivement « franchir ». Nous avons identifié cet obstacle comme étant de la forme d’une discontinuité déductive (mathématique).

Nous avons ensuite introduit un terme plus général – la singularité – qui subsume la discontinuité mathématique formelle, celle-ci étant un cas particulier de la classe générale des singularités.

Cela étant posé, nous allons maintenant nous intéresser à une autre sous-classe de singularités, le gouffre « infranchissable », mais non insurmontable, qui sépare deux « principes d’hérédité » : le principe de la déduction en général et le principe de la géométrie constructive (c’est-à-dire la véritable géométrie non euclidienne), ce dernier étant conforme au principe maximum-minimum de Nicolas de Cues [8].

Il nous faut maintenant examiner les similitudes apparentes et les différences qualitatives entre ce dernier principe, l’ordre supérieur de singularités constructives, et le précédent, les ordres déductifs inférieurs.

Considérons tout d’abord ce qui distingue les deux espèces différentes de réseaux de théorèmes dans la manière dont elles sont séparées par des singularités.

Dans les cas déductifs, les discontinuités séparant des réseaux de théorèmes différents sont formellement des « gouffres dont on ne peut relier les bords ».

La géométrie physique constructive est un domaine subsumant des réseaux de théorèmes relativement distincts. Par exemple :

- La géométrie synthétique élémentaire ébauchée par Jacob Steiner : c’est-à-dire, essentiellement, le champ de la géométrie euclidienne déductive « redéfini » d’une manière constructive, non euclidienne.

- Une géométrie synthétique élémentaire avancée faisant appel au principe maximum-minimum en termes de principes isopérimétriques multiplement connexes.

- Une géométrie synthétique élémentaire avancée comprenant la génération de cycloïdes, et de relations entre cycloïdes en termes de développées, développantes et d’enveloppes leibniziennes et mongiennes.

- Une géométrie synthétique avancée, reposant sur l’action spirale auto-similaire multiplement connexe, le domaine de Gauss, Dirichlet, Weierstrass, Riemann, etc. C’est le domaine complexe de la fonction riemannienne.

- La géométrie synthétique physique plus avancée du domaine complexe qui remplace une fonction riemannienne par une fonction de surface de Riemann-Beltrami. Celle-ci prend en compte les implications profondes de la courbure non algébrique de l’espace-temps physique. Eugenio Beltrami, le collaborateur de Riemann, avait en effet expliqué qu’il fallait une extension correctrice, la courbure négative, pour une version plus adéquate de la fonction riemannienne.

Aucune consistance réciproque n’est possible entre deux réseaux de théorèmes déductifs A, B, C, D, etc. Deux singularités séparées par un gouffre ne peuvent pas être « reliées ». Cette difficulté disparaît – devient surmontable – dans le domaine de construction conformément au principe maximum-minimum.

Tout d’abord, la différence entre n’importe lequel de ces modes et son successeur immédiat est l’acte d’intégration géométrique physique : l’ajout d’un « degré de liberté », d’une « dimension », à la forme dans laquelle l’action génératrice élémentaire est représentée. Ainsi, la singularité est parfaitement définie mais on peut la relier.

Ensuite, le point de vue de la géométrie synthétique nous permet de relier les discontinuités formelles séparant A, B, C, D, etc., grâce à la méthode découlant de la fonction riemannienne, alors que la méthode déductive ne le peut pas. Cette relation peut être illustrée par la projection élémentaire (riemannienne) stéréographique conforme, entre un plan dans un mode euclidien et une sphère dans un mode constructif.

Cela nous permet alors de procéder de la manière suivante.

Cela nous conduit à un objectif intermédiaire déterminant dans notre recherche d’une véritable définition moderne du sens commun. Il s’agit de l’opposition entre entropie et entropie négative (néguentropie). Dans le problème que nous allons soulever, nous devons dénoncer le programme d’enseignement des mathématiques d’avoir adopté le modèle d’Isaac Newton.

Newton avait averti ses lecteurs qu’il avait intégré dans sa physique mathématique une vision totalement absurde de l’Univers. Cette absurdité est ce que l’on désigne aujourd’hui dans le programme universitaire sous le nom d’« entropie universelle » ou seconde loi de la thermodynamique. Newton avait averti ses lecteurs qu’il est absurde de représenter notre Univers comme s’arrêtant à la manière du ressort d’une horloge mécanique. Il expliquait que la source de cette idée absurde en physique ne provenait pas d’une preuve expérimentale ; elle provenait du type de mathématique qu’il avait décidé d’utiliser.

Les défenseurs ultérieurs de l’« entropie universelle » tels que Kelvin, Maxwell et Boltzmann, étaient des admirateurs de Newton mais, à l’évidence, étaient moins intelligents ou moins honnêtes que ce dernier.

L’idée d’entropie universelle est inhérente à l’utilisation d’un quelconque choix de réseau de théorèmes déductif, en tant que base pour tenter de construire une représentation intelligible des processus physiques. C’est ainsi que tous ceux qui, comme Galilée, Descartes, Newton, Laplace, Cauchy, Clausius, Kelvin, Maxwell, Boltzmann, etc., ont adopté une mathématique déductive formelle comme base d’élaboration et d’interprétation expérimentales, semblent mettre en évidence une entropie universelle dans les processus physiques. Ceux qui, comme Nicolas de Cues, Léonard de Vinci, Kepler, Leibniz, Monge, Gauss et Riemann, ont au contraire adopté la méthode constructive, nous présentent un Univers dominé et imprégné par la néguentropie universelle.

Tant que l’on s’imagine qu’il n’existe qu’une seule sorte de mathématique, la déductive, il est presque impossible de voir quelles sont les implications ontologiques inhérentes à chacune des deux mathématiques. Ce n’est qu’après avoir saisi quelques-unes des différences fondamentales entre les méthodes déductive et constructive que l’on peut comprendre les observations de Leibniz au sujet de l’avertissement de Newton mentionné ci-dessus [9]. Voilà ce sujet mis en place dans notre réflexion.

Considérons deux aspects que l’on retrouve dans toute tentative de construire une physique mathématique selon le principe d’un réseau de théorèmes déductif quelconque.

La déduction commence par la supposition axiomatique selon laquelle l’existence du point idéal est évidente en soi, et n’est pas sujette à l’analyse. Cela conduit cependant à l’absurdité du point matériel qui, s’il n’a aucune masse, représente en revanche une densité de masse infinie par centimètre cube.

Dans la méthode constructive, le point ne nous conduit pas à un paradoxe. Il est créé et non évident en soi ; il est engendré par moindre action multiplement connexe.

Dans la physique déductive, le point matériel, ou la propagation le long d’une ligne « droite » auto-évidente, est la supposition minimale dans la forme de moindre action. Avec cette supposition, la physique devient une sorte de parodie idéologique de la géométrie déductive euclidienne, comme la méthode analytique de Descartes en est une illustration. Dans la physique constructive du Cusain et de ses successeurs, on a dès le départ un espace-temps physique non euclidien.

Pour la même raison, toute physique mathématique reposant sur le modèle des réseaux de théorèmes déductifs tend vers une représentation idéale sous la forme de solutions à un système d’inéquations linéaires, comme celles que John von Neumann a proposées de façon incompétente en économie [10]. En fait, la méthode déductive interdit la construction d’une représentation intelligible d’un processus continu non linéaire, processus du même type que celui représenté de manière plus ou moins adéquate par la fonction riemannienne.

Cela suffit pour affirmer un point : la méthode déductive impose à la physique mathématique un ensemble de suppositions ontologiques. Si nous soumettons les mêmes faits expérimentaux à la méthode constructive, nous aurons à la place une autre image ontologique. D’où l’avertissement de Newton : l’utilisation de la méthode déductive impose certaines suppositions ontologiques linéaires à la physique mathématique. L’idée d’entropie universelle n’est rien de plus qu’une autre manière d’énoncer les suppositions ontologiques de la méthode déductive.

Définir le type de fonction continue pour une survie réussie requiert un examen plus approfondi des fonctions reposant sur la néguentropie universelle. Nous allons maintenant nous concentrer sur la néguentropie universelle en tant que telle. Commençons par un survol rapide de l’histoire moderne de cette question.

La section d’or

L’idée de néguentropie universelle en tant que trait caractéristique des fonctions mathématiques (constructives géométriques) remonte aux débuts de la science physique moderne en Italie, au cours de la première moitié du XVe siècle. La méthode scientifique requise a été élaborée par Nicolas de Cues, comme nous l’avons déjà mentionné. Le travail du Cusain, ainsi que celui de Léonard de Vinci, ont directement conduit à la première élaboration d’une physique mathématique complète par Kepler. La question de néguentropie universelle est inséparable de celle de section d’or, comme on peut le voir dans la Divina Proportione de Luca Pacioli, et chez Kepler ensuite.

La relation entre l’idée de néguentropie universelle et celle de section d’or a été rendue possible quand le Cusain a élaboré, initialement dans son De Docta Ignorantia, de nouvelles fondations pour la physique mathématique : le principe maximum-minimum a servi de base pour une véritable géométrie physique constructive non euclidienne.

Comme nous l’avons indiqué dans le chapitre précédent, c’est notre connaissance de l’existence d’une méthode totalement opposée à la déductive qui nous encourage à découvrir la qualité axiomatique des suppositions ontologiques contenues dans la méthode déductive. Ainsi, nous sommes également capables de reconnaître les implications ontologiques élémentaires de la géométrie physique constructive. Elle nous permet donc de penser à la science comme un tout, d’une manière nouvelle, plus profonde, plus complète et bien plus efficiente.

Passons donc aux implications modernes de la section d’or.

Le Cusain avait déjà reconnu la caractéristique ontologique centrale qui découle de son principe maximum-minimum. Il associait sa méthode à sa vision d’un Univers noétique caractérisé par une évolution vers le progrès. Par ailleurs, ses travaux sur les fondements d’une science physique moderne ont rendu possibles ceux de ses successeurs directs tels que Léonard de Vinci, Kepler et Leibniz.

A partir du moment où nous admettons que chaque type de méthode mathématique mutuellement inconsistante possède un ensemble inhérent et exclusif de qualité axiomatique de suppositions ontologiques, nous comprenons que ce caractère exclusif lui est universel (« héréditaire »). Cet aspect exclusif est par ailleurs ce que l’on appelle le type spécifique de caractère auto-délimité de l’Univers physique, implicite dans chacun des types spécifiques de méthode mathématique choisie.

Dès que l’on commence à examiner la mathématique comme une physique implicite tout en gardant ce qui précède à l’esprit, nous pouvons considérer la mathématique elle-même d’un nouveau point de vue.

A titre d’exemple, regardons rapidement la question des nombres premiers. Il y a deux manières de voir ce phénomène : l’une déductive, l’autre basée sur la géométrie constructive.

Le point de vue scolaire et futile est celui, déductif, de la foi cabalistique de Léopold Kronecker dans l’auto-évidence magique du comptage des nombres. Avec le point de vue déductif, la recherche sur les nombres premiers est entraînée vers la quête, sans espoir, de la fin inexistante du labyrinthe orphique de la théorie des nombres.

A l’opposé, l’approche géométrique constructive, mise en œuvre successivement par Leonhard Euler, Lejeune-Dirichlet et Riemann, débouche sur la fonction Euler-Dirichlet-Riemann pour déterminer la densité de nombres premiers dans un intervalle. Les déductionnistes, obligés de reconnaître la réussite de la fonction riemannienne, ignorent les moyens par lesquels cette fonction a été construite mais utilisent, par contre, des ordinateurs pour éprouver la fonction riemannienne selon les critères déductifs de la théorie des nombres. Ces déductionnistes ont réussi à apprendre comment échapper à la compréhension de quoi que ce soit de fondamental en matière de méthode scientifique !

Riemann montre que la détermination du « caractère premier » de ces nombres appartient au domaine complexe de Gauss-Riemann qui est construit sur la base de l’action spirale auto-similaire multiplement connexe.

De même, nous avons d’autres formes de phénomènes, possédant cette qualité expérimentale fondamentale, qui mettent en évidence les incapacités axiomatiques de la méthode déductive. Construisons par exemple, à partir de la géométrie euclidienne, une représentation intelligible de l’existence nécessaire d’un heptagone régulier ; c’est impossible dans cette géométrie, mais cela peut être réalisé de manière élémentaire dans une géométrie constructive reposant sur l’action spirale auto-similaire multiplement connexe.

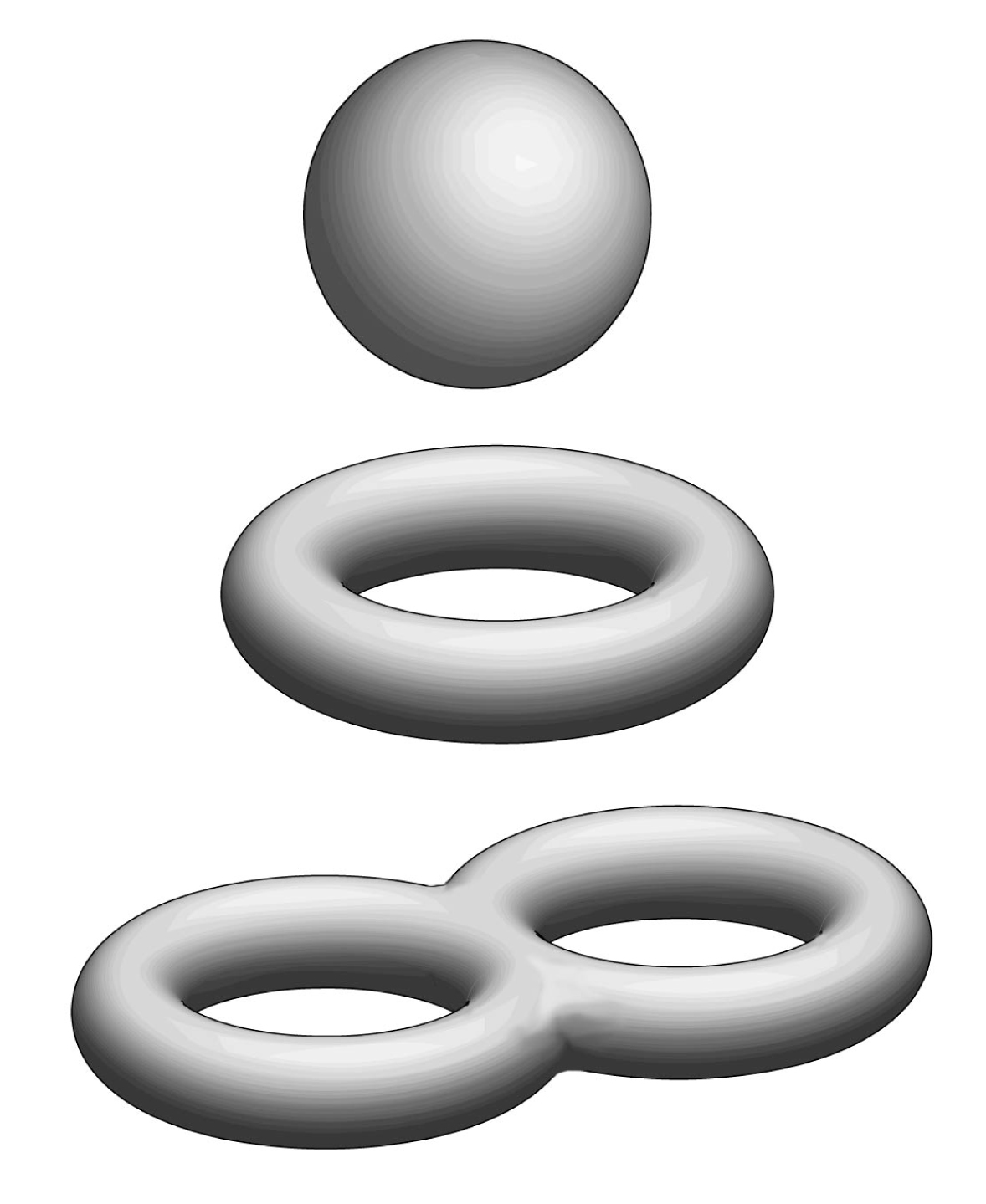

Le phénomène le plus important du domaine euclidien en géométrie, est la section d’or. Sa signification s’impose à nous par le fait qu’il n’est pas possible de construire plus de cinq espèces de polyèdres réguliers dans l’espace euclidien, ou dans un espace constructif reposant sur l’action circulaire triplement connexe. Parmi ces cinq solides réguliers (platoniciens), un seul possède un caractère unique, le dodécaèdre ; les quatre autres sont simplement dérivés, par construction, de celui-là. La construction du dodécaèdre, ainsi que des douze pentagones réguliers qui forment ses faces, est déterminée par la construction de la caractéristique de l’action circulaire multiplement connexe de la section d’or.

Ceci nous montre que la géométrie euclidienne et l’espace-temps physique de l’action circulaire triplement connexe partagent une délimitation correspondante. Nous dirons donc que de tels espaces sont finis, en réalité délimités extérieurement mais également auto-délimités.

Ces exemples, tels que les nombres premiers, l’heptagone régulier, les solides platoniciens, mettent en évidence des discontinuités séparant le monde intérieur de ces géométries de la réalité universelle bien plus large dans laquelle ces géométries se trouvent. Ainsi, ces géométries prises comme un tout sont finies. Du fait qu’elles sont délimitées par des singularités qui n’ont pas de représentations intelligibles constructibles dans ces géométries elles-mêmes, ces géométries sont finies par délimitation externe. Cependant, dans la mesure où elles ne peuvent pas atteindre et inclure leurs propres limites de manière intelligible, elles sont auto-délimitées par une limite presque au seuil des délimitations externes.

En matière de physique mathématique, ce dont nous avons besoin, c’est d’une méthode qui définisse notre Univers physique comme fini et délimité, mais de telle sorte que ces délimitations soient construites comme des représentations intelligibles par la méthode de cette même physique mathématique complète. Dans cette recherche, la section d’or a une signification empirique particulière.

La signification physique surprenante de la section d’or a été élaborée par les associés de Léonard de Vinci : à l’échelle macroscopique ordinaire (de l’homme) tous les processus vivants sains présentent des formes de croissance et de mouvement qui sont déterminés harmoniquement par, et donc en congruence avec, les ordonnancements harmoniques subsumés par la section d’or. A cette échelle ordinaire d’observation, tous les processus vivants sont ordonnés de cette manière, mais ce n’est pas le cas pour les processus non vivants.

Cette caractéristique harmonique des processus vivants a été la définition empirique originelle de la conception que l’on désigne aujourd’hui par néguentropie. Par contre, l’harmonie des processus non vivants est la référence empirique originelle de la notion mathématique d’entropie.

Cette distinction entre ce que nous appelons entropie et néguentropie n’a pas seulement été soutenue par Kepler [11] ; elle est également la caractéristique centrale de toute la physique mathématique de Kepler et de ses successeurs tels que Leibniz, Gauss et Riemann [12]

Cette question de néguentropie et d’entropie prend une signification plus riche lorsque nous étendons notre champ d’observation aux échelles extrêmes que sont l’astrophysique et la microphysique. La physique de Kepler, dont la justesse a été prouvée par Gauss en ce qui concerne les astéroïdes, montre également de manière concluante que l’Univers, dans son ensemble, est gouverné et imprégné par un principe de néguentropie, dans le sens exactement opposé à ce que défendaient avec insistance Clausius, Kelvin, Maxwell et Boltzmann. C’est ainsi que confronté à un choix entre la vie (néguentropie) et la mort (entropie), Boltzmann a choisi la mort.

Nous retrouvons le même résultat dans le domaine de la microphysique : les ordonnancements géométriques caractéristiques des processus relativement élémentaires aux échelles atomiques et subatomiques sont « keplériens ».

On voit ainsi à trois échelles – la vie, l’astrophysique et la microphysique – que l’Univers dans son ensemble est néguentropique. L’entropie existe dans un tel Univers mais seulement en tant que caractéristique nécessaire et subordonnée à la néguentropie universelle. Cette néguentropie est la nature de la substance.

Cela nous ramène à la fonction exprimant le taux d’accroissement du potentiel de densité démographique. Cette fonction, exprimée en tant que fonction continue, présente la caractéristique harmonique d’un processus néguentropique (vivant). L’augmentation du pouvoir de l’humanité sur la nature, exprimée comme une augmentation du potentiel de densité démographique, est la néguentropie.

Pour localiser la source du gain de néguentropie pour l’homme, nous devons enquêter sur la source du progrès scientifique et technologique. On en revient donc à notre examen de Kant.

Cas d’étude : l’économie américaine

Pour définir le véritable sens commun, nous devons connaître les conditions dans lesquelles on forge l’opinion d’une société afin de rendre celle-ci capable d’une survie réussie. Nous devons savoir comment l’homme – la société – est capable de maîtriser l’Univers afin d’accomplir une survie réussie. Nous devons déterminer où se situe la faculté de l’homme à savoir ce qu’il doit maîtriser en vue d’un tel effet ; nous devons situer le choix conscient des moyens par lesquels l’individu dans la société peut reconnaître une telle faculté, et décider effectivement de l’exercer.

A cette fin, nous allons continuer à explorer certaines des plus importantes caractéristiques de l’esprit et de la nature.

J’ai déjà signalé plus haut que l’activité mentale créatrice est exprimée par la transformation (A → B) à condition que cette dernière génère, au moment B, une condition (un potentiel) déterminant la survie réussie future, en terme des effets de transformation (B → C), (C → D), etc.

L’impressionnante difficulté à définir une conception appropriée de potentiel au moment B, n’est qu’apparente. Le concept de « hiérarchie » d’ordonnancements transfinis nous donne une indication sur la solution recherchée [13].

Tournons maintenant notre attention vers le domaine de l’art de gouverner.

Depuis 1963 jusqu’aujourd’hui en 1989, une faction majoritaire dans l’establishment libéral anglo-américain, favorable au « nouvel âge », a ouvertement encouragé à ce qu’une révolution contre-culturelle fondée sur « l’âge du Verseau » de Nietzsche et de Crowley soit imposée au sein des institutions publiques et des faiseurs d’opinion populaire en général. Au cours de cette période, on a connu de nombreux changements de politique, parfois très marqués, mais allant presque toujours dans la même direction : de plus en plus éloignés des traditions économiques, morales et culturelles de la civilisation judéo-chrétienne de l’Europe occidentale, et de plus en plus proches de l’utopie gnostique, parfois ouvertement satanique et toujours malthusienne de la « société postindustrielle ».

Considérons le point de vue philosophique et politique des incitations fiscales à l’investissement et du programme aérospatial à marche forcée du Président Kennedy comme caractéristique du moment A. Soit donc A ≡ 1961, et l’année fiscale 1966-1967 représentant B, pour la transformation « entropique » T(A → B).

L’ adoption par le Président Lyndon Johnson d’un programme malthusien (comprenant l’abandon de l’aérospatial) a conduit l’économie des États-Unis à des taux de croissance réelle inférieurs à ceux des politiques précédentes de Kennedy. Plus grave que les changements économiques assez désastreux que Johnson a effectués en 1966-1967 : un changement d’orientation dans la politique américaine et atlantique s’est opéré au même moment. La résurgence du dogme religieux gnostique, sous forme d’« environnementalisme » et de « consumérisme », a remplacé les critères d’orientation politique correspondant à une société civilisée.

Or, à quelques rares exceptions près (qui, selon le proverbe, confirment la règle), la survie humaine dépend relativement moins des politiques du moment que du choix d’orientation politique qu’effectue la société.

Considérons donc les processus économiques en tant que tels dans les termes de ce qui précède.

Pour avancer dans la discussion, identifions deux conséquences du moment B, l’une est la conséquence objective, c’est-à-dire les changements physiques dans le processus économique au cours du moment B, et l’autre est l’état synchronisé (« subjectif »).