Pour présenter l’oeuvre posthume du célèbre physicien allemand Bernhard Riemann (1826-1866), Lyndon LaRouche montre ici les aspects les plus pertinents de ses découvertes pour les problèmes d’économie physique.

A cette fin, il expliquera d’abord l’importance des discontinuités mathématiques dans son œuvre et ensuite pourquoi il accorde une telle importance à ce qu’il appelle Geistesmassen dans ces textes posthumes.

Lyndon LaRouche est économiste et fondateur du magazine scientifique international Fusion. Il est l’auteur de nombreux ouvrages sur la méthode scientifique et la philosophie des sciences.

Ce texte a d’abord été publié dans 21st Century, Hiver 1995-1996 sous le titre : « Riemann Refutes Euler : Background to a Breakthrough » avant de paraître en français dans le magazine Fusion, à titre d’introduction à la première traduction en français d’un ensemble d’écrits de jeunesse du célèbre physicien allemand Bernhard Riemann (1826-1866) publiés après sa mort. [1] L’intérêt de ces textes est de fournir le contexte indispensable pour comprendre comment Riemann a pu développer ses découvertes révolutionnaires de la période 1853- 1854. [2]

L’intérêt particulier de ces fragments réside dans le fait qu’il n’existe pas d’évaluation compétente de l’œuvre de Riemann si l’on ne considère pas ses écrits, ainsi que ceux de Weierstrass, comme une réfutation dévastatrice de l’attaque virulente que lança Leonard Euler contre Gottfried Leibniz. [3] Le problème formel, qui se dégage d’une discussion sur les séries mathématiques, consiste à savoir si les discontinuités mathématiques existent ou non. [4] En ce qui concerne ces attaques contre Leibniz de la part des newtoniens du XVIIIe siècle, Samuel Clarke et Leonard Euler, le problème particulier sous-jacent est de déterminer si la physique est une branche des mathématiques ou si les mathématiques sont une branche de la physique. Cette question est encore plus d’actualité aujourd’hui qu’à l’époque de Riemann.

Comme il l’énonce dans la conclusion de sa célèbre dissertation d’habilitation de 1854, Riemann a démontré que pour poser les fondements des mathématiques, on doit quitter ce domaine pour aller dans celui de la physique. [5] En affirmant cela, Riemann, tout comme Carl Gauss avant lui, se situe entièrement dans le domaine de la physique plutôt que dans celui de la réalité virtuelle associée à l’influence de Bertrand Russell et du golem de Bourbaki sur lequel repose en grande partie l’enseignement actuel des mathématiques. Les fragments posthumes que l’on présente ici sont directement liés à la façon dont Riemann a développé sa démarche sur cette question.

Riemann et la science économique

Par Lyndon LaRouche, 1995.

L’intérêt que porte Fusion à Riemann est lié aux recherches que j’ai menées dans une branche de la science physique fondée par Leibniz connue sous le terme d’économie physique. Mes découvertes dans ce domaine ont fourni l’impulsion principale pour créer dans les années 70 la Fondation pour l’énergie de fusion qui, ensuite, a donné naissance au magazine Fusion. Bien que les travaux de Riemann ne soient pas à l’origine de la plupart de mes découvertes, l’approche adoptée pour résoudre les problèmes mathématiques posés par ces découvertes a presque entièrement été suscitée par la dissertation d’habilitation de Riemann, d’où la dénomination « méthode LaRouche-Riemann ». [6]

Pour présenter les papiers posthumes de Riemann, je vais indiquer quels sont les aspects de sa dissertation qui sont les plus pertinents pour les problèmes d’économie physique. A cette fin, nous allons d’abord considérer la place que les discontinuités mathématiques occupent dans la découverte de Riemann, et ensuite expliquer pourquoi celui-ci accorde une telle importance à ce qu’il appelle « Geistesmassen » dans ces textes posthumes.

Dans un premier temps, afin de bien comprendre l’importance des discontinuités mathématiques, je vais exposer le point de départ de la dissertation de Riemann selon mes propres termes.

On situe l’origine des mathématiques modernes dans ce qui est en général assimilé à une notion « euclidienne » d’espace-temps simple. Cette idée d’espace-temps prétend représenter l’univers réel, ce qui est faux. Cette idée n’est pas une création des sens mais plutôt de l’imagination naïve. On imagine simplement que l’espace est défini par trois dimensions – hauteur, largeur, profondeur – qui peuvent s’étendre sans limite et selon une continuité parfaite. On imagine aussi que le temps est une dimension unique, sans limite et parfaitement continue : avant-arrière. Considérées ensemble, ces présomptions définissent une variété d’espace-temps à quatre dimensions ou, en d’autres termes, une variété d’espace-temps quadruplement étendue.

L’imagination naïve tente de placer les corps perceptibles et leurs mouvements dans une telle variété quadruplement étendue. On pourrait dire que notre variété d’espace-temps imaginaire est une sorte de miroir mental sur lequel nous essayons de projeter le reflet des mouvements des corps de l’espace-temps. Le résultat de telles projections est une espèce « euclidienne » simple de mathématique algébrique qui, comme on va le découvrir, n’est pas une mathématique de l’univers réel.

Des expériences classiques, telles que celle de la mesure de la courbure de la surface terrestre par Eratosthène [7], nous donnent une démonstration mesurable que le mouvement des corps dans l’espace-temps physique ne correspond pas à ce que nous suggère une notion algébrique naïve d’espace-temps. Nous devons y ajouter des « dimensions » autres que l’espace-temps, comme les notions de « masse », de « charge », etc., pour constituer une mathématique en accord avec notre mesure des mouvements qui, à partir de l’espace-temps physique, sont reflétés sur ce miroir imaginaire que l’on appelle « espace-temps simple ». [8]

Ainsi, si nous essayons d’explorer l’espace-temps physique, nous sommes confrontés à une variété d’espace-temps physique d’un plus grand nombre de dimensions que les quatre dimensions de l’espace-temps naïf. Ces facteurs ajoutés, nous les appelons « dimensions » car on peut les mesurer selon le principe d’ordonnancement de « plus grand que » et « plus petit que », comme c’est le cas avec les dimensions de l’espace-temps naïf. Au lieu de parler de n+4 dimensions, nous incluons les quatre dans le décompte de n ; ainsi, on parlera d’une « variété d’espace-temps physique à n dimensions ». On essaye en général de représenter le mouvement dans cet espace-temps physique à n dimensions dans les termes de son reflet imaginaire sur un espace-temps à quatre dimensions.

Dans tous les cas, l’ajout d’une nouvelle « dimension » valide à la variété d’espace-temps physique de référence, correspond à un changement dans la manière de mesurer, un changement de l’outil que nous devons employer pour mesurer le mouvement en question, ou une forme analogue d’action. Par exemple, Eratosthène estimait que la Terre était un sphéroïde d’environ 12 600 km de diamètre entre les deux pôles (Annexe 1). [9] Cela signifie que pour mesurer le mouvement sur la surface de la Terre, nous devons prendre comme outil de mesure la trigonométrie sphérique plutôt que la simple géométrie euclidienne plane. De même, après qu’Ole Rømer ait montré en 1676 que le rayonnement de la lumière était gouverné par un principe de potentiel retardé, Christiaan Huygens a généralisé en 1677 les principes de réflexion et de réfraction en conséquence [10], et Jean Bernoulli avec Leibniz ont démontré que les mathématiques du domaine transcendantal de la relativité devaient remplacer les méthodes algébriques de Galilée, Descartes et Newton. [11]

Le défi dont il est ici question, consiste à valider, par la mesure, l’ajout nécessaire d’une telle dimension physique. Un tel ajout signifie que pour la variété d’espace-temps physique de dimension n, n est remplacé par (n+1). Cela nous donne un terme généralisé de topologie que l’on peut exprimer symboliquement par n → (n+1). A la série de changements de n à n+1 dimensions, correspond une série de changements dans le choix de l’outil que nous devons utiliser pour mesurer l’action physique considérée. [12]

C’est le même problème auquel nous sommes confrontés en économie physique, quand on essaie de définir la correspondance entre le progrès scientifique et technologique, d’une part, et l’augmentation générale résultante dans les pouvoirs productifs du travail, par tête, par ménage et par kilomètre carré, d’autre part. Dans ce cas précis, le type d’outil de mesure utilisé s’appelle potentiel de densité démographique relative ; celui-ci change d’échelle (par tête, par kilomètre carré) au fur et à mesure que le niveau de progrès scientifique et technologique appliqué avance.

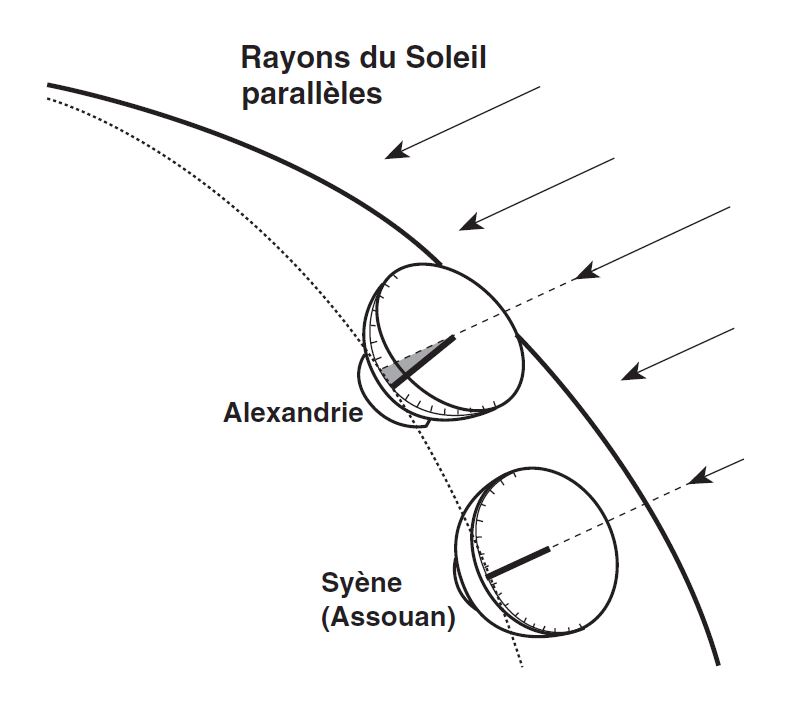

Annexe 1 : La découverte d’Eratosthène

Au IIIe siècle avant J.-C., Eratosthène mesura l’ombre portée du Soleil sur des gnomons identiques placés dans les villes égyptiennes d’Alexandrie et de Syène, à environ 800 km au sud d’Alexandrie.

Chaque gnomon étant perpendiculaire à la Terre, on procédait aux mesures à midi, le jour du solstice d’été. On ne constata aucune ombre à Syène, alors que l’on observa une ombre de 7,2 ° à Alexandrie.

C’est sur cette base qu’Eratosthène conclut que la Terre était sphéroïde, deux mille trois cents ans avant que l’on puisse le constater de visu à partir de l’espace. Connaissant la distance entre les deux villes, il put aussi calculer la circonférence de la Terre sur laquelle il ne fit qu’une erreur de 80 km. L’importance de son expérience ne tient pas tant à cette remarquable exactitude, qu’à sa démonstration que la connaissance ne repose pas sur l’observation par les sens mais sur l’étude des paradoxes découlant de l’observation. La découverte d’Eratosthène contient en germe les principes essentiels communs à toute découverte expérimentale fondamentale valide de principes physiques universels.

Science et métaphore

Bien qu’elles soient très profondes, toutes les questions posées par la dissertation d’habilitation de Riemann sont si élémentaires que tout bachelier de bon niveau devrait pouvoir les comprendre. Une fois que l’on a reconnu l’intention qu’il y exprime, on se rend compte que cette dissertation est l’un des textes les plus lucides qui ait jamais été écrit dans toute la littérature des découvertes scientifiques fondamentales. Il est vrai que la plupart des commentateurs qui « font autorité » dans l’enseignement ont véhiculé une vision confuse de ce texte. La faille de tous ces commentaires réside dans le fait que leurs auteurs, tout en refusant de reconnaître ce que Riemann exprime, projettent sur lui une intention axiomatiquement contraire à la sienne.

Les erreurs axiomatiques de ces commentateurs ont lieu à deux niveaux.

A un premier niveau, ils cherchent à prendre le parti de figures comme Newton, Euler, Augustin Cauchy, etc., qui, depuis 1815, font autorité dans l’enseignement des mathématiques et cela malgré la réfutation implacable dont ils ont fait l’objet et qui découle de la découverte de Riemann. Tout ceci tourne autour de l’argument d’Euler contre Leibniz. Ce point de vue axiomatique relativement plus superficiel, c’est l’insistance avec laquelle les positivistes affirment que, finalement, les discontinuités mathématiques n’existent pas. [13]

A un niveau plus profond, on trouve une question plus dévastatrice dont les opposants à Leibniz et Riemann refusent de débattre.

Les positivistes radicaux du culte Bourbaki sont une illustration de cela. Ces idéologues positivistes partagent un déisme ockhamiste particulier. Il s’agit du dogme selon lequel toutes les questions de la science doivent être résolues à l’aide de preuves mathématiques énoncées sur un tableau noir ou par un ordinateur. Toute démonstration prouvant que le formalisme mathématique n’est pas le dieu de la science, qu’elle vienne de Platon et de son Académie ou de modernes tels que Leibniz et Riemann, met ces positivistes dans une rage irrationnelle qui n’est pas sans rappeler l’esprit et la rationalité des meutes jacobines de Marat et de Danton.

Cette question axiomatique plus profonde est à l’origine de la mission que l’abbé Antonio Conti a assignée à Samuel Clarke pour attaquer Leibniz. C’est la raison des attaques posthumes virulentes qu’Euler, issu également des salons de Conti, porta contre Leibniz. Cette question constitue aussi la raison des attaques haineuses conduites par les disciples d’Ernst Mach contre Max Planck au cours de la Première Guerre mondiale. [14]

Une fois accepté le fait historique premier de connaissance en physique mathématique, c’est-à-dire que chaque découverte de principe physique validée par la mesure appropriée met les mathématiques face à un défi topologique de la forme n → (n+1) indiquée ci-dessus, on voit se dissiper l’autorité quasi religieuse du formalisme mathématique que les disciples d’Euler et du culte Bourbaki défendent si fanatiquement (Annexe 2). [15] Comme dans le cas de Leibniz avant lui, la découverte de Riemann montre que les systèmes formels de physique mathématique ne recèlent pas le potentiel d’une doctrine de vérité. Pour trouver la vérité, nous devons quitter le domaine des mathématiques et aller dans un autre domaine, celui de la physique expérimentale.

La clef de toutes ces questions de physique mathématique et de celles qui leur sont formellement associées, c’est le lien entre, d’une part, l’insistance avec laquelle on affirme à tort que, finalement, les discontinuités n’existent pas en mathématiques et, d’autre part, l’affirmation plus profonde (également erronée), présente dans le dogme de Bourbaki, selon laquelle les mathématiques pourraient être une doctrine de vérité.

On peut dire que toute physique mathématique consistante d’une variété spécifique d’espace-temps physique à n dimensions, peut être considérée comme un réseau déductif formel de théorèmes. Suivant cette interprétation, il apparaît que chaque théorème de ce réseau contient l’attribut lui permettant d’être une proposition pour laquelle il a été démontré qu’elle est consistante avec tout ensemble d’axiomes et de postulats sous-jacent à la totalité de ce réseau. [16] Un tel ensemble d’axiomes et de postulats est désigné par Platon aussi bien que par Riemann par le terme d’hypothèse, par opposition à l’utilisation incorrecte que fait Newton du même terme dans son célèbre « hypotheses non fingo ». [17]

L’utilisation correcte du terme « hypothèse » apparaît sans ambiguïté à la simple lecture du titre de la dissertation de Riemann, avant même de rentrer dans le corps du texte. Pour procéder à une lecture compétente de la dissertation de Riemann, il faut comprendre qu’une transformation topologique, exprimée par la transition d’une variété mathématique d’espace-temps physique à n dimensions vers une variété à (n+1) dimensions, est une transformation dans l’ensemble des axiomes et des postulats sous-jacents à la physique mathématique.

En conséquence, l’histoire de ces découvertes de principes physiques validées par une mesure adéquate, nous présente une succession de changements topologiques dans la physique mathématique, une série de changements qui a la forme du paradoxe du Un et du Multiple présent dans le Parménide de Platon. Dans cet exemple, le Multiple est représenté par une série d’hypothèses ; le défi qui se pose est de découvrir un principe supérieur, une hypothèse supérieure – un Un – qui définit un principe générateur au moyen duquel la série d’hypothèses – le Multiple – est ordonnée « de façon transfinie ». Si la dissertation de Riemann est interprétée autrement que dans ce sens platonicien, le commentaire qui en résultera sera scientifiquement incompétent quelle que soit la réputation du commentateur.

Riemann adopte une vision de la physique mathématique basée sur la succession des progrès dans ces découvertes de principes physiques validées par des mesures cruciales adéquates (l’estimation de la courbure de la Terre par Eratosthène est une illustration de ce principe de mesure). Le point de vue riemannien de cette transformation topologique sous-jacente au progrès de la physique mathématique, définit donc le progrès en termes physiques mathématiques comme étant une séquence de discontinuités mathématiques absolues dans une lecture formaliste de la physique mathématique. Selon ce point de vue, Newton, Euler et Cauchy, par exemple, apparaissent comme les victimes de leur propre incompétence scientifique, victimes du paradoxe ontologique de la forme du Un et du Multiple qu’ils n’ont pu ni résoudre ni comprendre et, semble-t-il, ne souhaitaient même pas comprendre.

Dans tous les cas, un réseau de théorèmes formel se distingue d’un autre par un changement quelconque entre le contenu axiomatique de l’hypothèse sous-jacente à l’un et le contenu axiomatique de l’hypothèse sous-jacente à l’autre. Chaque théorème du second réseau est formellement inconsistant avec tout théorème du premier. La différence entre les deux hypothèses est une discontinuité mathématique véritable et relativement absolue. Une telle « discontinuité » a la même signification en physique mathématique que le terme « métaphore » dans les formes classiques de poésie ou de théâtre. La signification de « discontinuité », pour le formalisme d’une physique mathématique consistante, est précisément la même que celle de « métaphore » pour un poème classique ou une pièce de théâtre. [18] La compréhension de cette relation entre métaphore et discontinuité mathématique est la clef du premier des documents posthumes publiés ci-après et intitulé Sur la psychologie et la métaphysique.

En physique, une discontinuité mathématique se manifeste sous la forme d’une simple marque. La grandeur de cette marque est d’une transinfinitésimale petitesse, si petite qu’aucune grandeur arithmétique calculable ne peut la mesurer. Pourtant, elle existe comme phénomène : elle apparaît comme une marque de séparation entre toutes les grandeurs qui sont plus petites, et toutes celles qui sont plus grandes. [19] Cette marque est le signe de la présence fonctionnelle, hors du royaume du formalisme mathématique, de la forme physique mathématique de ce que nous appelons métaphore en poésie classique.

Annexe 2 : L’erreur d’Euler

En ce qui concerne les relations physiques de cause à effet, l’espace-temps physique est-il une simple extension linéaire ? L’astrophysique de Kepler nous dit que non : les orbites planétaires disponibles ne sont pas seulement limitées en nombre, dans le sens où elles sont dénombrables, mais que cette énumérabilité est elle-même définie par un principe très précis, susceptible de représentation intelligible, que l’on nomme « ordonnancement harmonique », et qu’en dehors des valeurs satisfaisant à un type particulier d’équation diophantienne, pour les valeurs qui se trouvent entre ces valeurs énumérables, harmoniquement ordonnées, il n’existe pas d’états de nature similaire.

Ceci introduit la nature discrète de l’espace physique en tant que tel. Cette nature discrète de la physique est le premier aspect d’une monade à l’échelle microscopique.

En reconnaissant les implications de la vitesse de la lumière comme singularité à l’échelle astrophysique et que la vitesse de la lumière a un équivalent en termes de singularité à l’échelle microphysique, nous voyons alors où se situe le sophisme de l’argument d’Euler en géométrie physique. Si nous reconnaissons que la connexion entre le microcosme et le macrocosme, le minimum et le maximum, est le changement, où le changement possède une qualité de non-entropie généralisée, dont la raison créatrice est typique... alors le problème s’évanouit.

Ainsi, le problème pour Euler touche à sa définition de l’extension et à l’utilisation d’une définition linéaire de l’extension. Euler exclut de ce fait de la réalité physique, par principe, les domaines de l’astrophysique et de la microphysique. C’est là où Leibniz ne se trompa point alors qu’Euler, au moins dans ce cas, se trompa.

Extraits des Lettres à une princesse allemande écrites par Euler en 1761 :

Lettre 8 : « La controverse entre les philosophes modernes et les géomètres [...] touche à la divisibilité des corps. Cette propriété est sans doute fondée sur l’extension. […]

« En géométrie, il est toujours possible de diviser une ligne, aussi petite soit-elle, en deux parties égales. De même, cette science nous enseigne la méthode permettant de diviser une petite ligne... en autant de parties égales que nous le désirons... »

Lettre 10 : « Certains affirment que cette divisibilité va jusqu’à l’infini, sans qu’il soit jamais possible d’arriver à des particules si petites qu’elles ne sont plus susceptibles d’autre division. Mais d’autres [Leibniz, Ndlr] affirment que cette division ne peut aller que jusqu’à un certain point, et que l’on peut au bout du compte en arriver à des particules si minuscules que, n’ayant plus de grandeur, elles ne sont plus divisibles. Ces particules ultimes, qui entrent dans la composition des corps, ils les appellent des êtres simples et des monades. […]

« Les partisans des monades, en maintenant leur opinion, sont obligés d’affirmer que les corps ne sont pas étendus. [...] Mais si le corps n’est pas étendu, je serais heureux de savoir d’où nous avons tiré l’idée d’extension ; car si le corps n’est pas étendu, rien ne l’est dans le monde, puisque les esprits le sont encore moins. Notre idée de l’extension serait donc à la fois imaginaire et chimérique.

« La géométrie serait de même une spéculation entièrement illusoire et inutile, et ne pourrait trouver aucune application aux choses réellement existantes. [...] »

Les « Geistesmassen » de Riemann

Le fait que toutes les véritables métaphores soient des singularités est la clef pour bien comprendre l’utilisation par Riemann du terme Geistesmassen, que l’on peut traduire par « masses-pensées », dans le texte Sur la psychologie et la métaphysique. Pour illustrer le principe en question, considérons le cas d’une métaphore dans une forme classique de poème strophique ou la mise en musique d’un tel poème par Mozart [20], Beethoven, Schubert, Schumann, ou Brahms. [21] Cet exemple du poème ou de sa mise en musique selon les principes de composition à motif directeur, est essentiel pour comprendre les processus mentaux par lesquels est générée une découverte valide d’un nouveau principe physique. [22] Il s’agit aussi d’un exemple de la conception présente dans la manière dont Platon aborde le paradoxe ontologique du Un et du Multiple dans son Parménide et dans d’autres dialogues tardifs. [23]

Dans un poème classique réussi, comme le simple Mailied de Goethe [24], les strophes représentent un ensemble de métaphores qui tendent, dans leur succession, vers une conclusion. L’attribution métaphorique de chaque strophe est générée par des ironies, de telle manière qu’aucune attribution purement littérale ou symbolique n’est permise pour cette strophe en particulier. La métaphore finale, en particulier son couplet final, change radicalement l’attribution métaphorique – par exemple, la « signification » – du poème dans son ensemble. C’est cette métaphore finale et subsumante qui révèle l’idée du poème pris dans son ensemble.

Une lecture correcte d’un tel poème, ou sa mise en musique classique, requiert un examen répété de l’ensemble, jusqu’au moment où deux conditions sont satisfaites : premièrement, que soit claire l’idée du poème dans son ensemble ; deuxièmement, que soit claire la relation entre chaque étape de la progression dans le poème jusqu’à sa conclusion. [25] En satisfaisant ces conditions, on établit, dans l’esprit, l’idée de l’ensemble du poème comme étant le produit d’une tension entre deux qualités réellement platoniciennes d’idée. La première est l’idée du poème pris dans son ensemble ; cette idée reste inchangée, du début de la relecture de la première ligne jusqu’au silence momentané qui suit la lecture de la dernière ligne. La deuxième idée est la suite de métamorphoses que subit l’idée du poème depuis le début jusqu’à la fin. Chez Platon, cette dernière qualité d’idée est appelée le devenir. C’est la tension entre la conception fixe, l’idée du poème pris dans son ensemble et le caractère métamorphique du processus de devenir, par laquelle l’idée parachevée est atteinte et qui constitue « l’énergie » du poème.

Les mêmes conditions s’appliquent à l’exécution de n’importe quelle composition musicale classique. Dans ce cas le plus simple, c’est la mémoire du musicien, en parachevant (terminant) la composition, qui crée la tension de rejouer la métamorphose, la tension entre l’idée parachevée de la composition et le moment du développement où l’on se trouve au cours de l’interprétation.

La singularité en question est générée par la différence de direction temporelle – en avant et en arrière – des deux idées qui interagissent dans le poème ou dans la composition musicale pendant l’interprétation.

C’est le même principe qui caractérise la façon dont Eratosthène a estimé la courbure de la surface de la Terre : le principe de développement découvert en expérimentant à nouveau les mesures individuelles des cadrans solaires mutuellement contradictoires, afin de trouver un principe générateur de changement qui est consistant avec le résultat final. Pour Eratosthène, la clef du principe générateur, c’est la relation entre le périmètre d’un cercle et un faisceau de lignes partant de la position momentanément fixe d’un point correspondant au Soleil et allant jusqu’à la Terre. C’est ainsi qu’Eratosthène a donné une estimation acceptable de la courbure de la Terre, environ vingt-deux siècles avant que quelqu’un puisse la voir.

Ces exemples dans la poésie, la musique et les travaux de l’Académie de Platon, illustrent tous la notion d’idée platonicienne, la qualité d’idée à laquelle Riemann assigne le terme de Geistesmassen. En général, dans les sciences physiques, de telles idées se manifestent tout d’abord sous la forme d’inconsistances vicieuses constatées dans des observations effectuées à l’aide des perceptions sensorielles. Ces inconsistances rendent ridicules aussi bien la certitude des sens que l’opinion scientifique généralement acceptée. Assez souvent, ce ridicule apparaît de la manière la plus cruellement dévastatrice. Avec comme objectif d’identifier le principe générateur responsable de ces paradoxes, ces idées validées par des mesures adéquates constituent des découvertes valides de principes physiques. Ces qualités de principes prouvés sont ce que l’on appelle classiquement des idées platoniciennes. Toute idée validée de « dimensionnalité » dans une variété d’espace-temps physique à n dimensions, possède cette qualité d’idée platonicienne.

Ainsi, toutes ces idées ont la forme de singularités paradoxales par rapport au domaine mathématique de référence préexistant. Le caractère singulier de ces idées vient de la manière subjective dont leur existence est générée : par le même type de processus sous-jacent à la lecture et à la composition d’un poème classique valide. La qualité de « singularité », et la forme associée de discontinuité mathématique, provient des directions opposées du temps associées à l’interaction entre les idées parachevées et le processus de leur développement. [26]

Ces métaphores ne peuvent jamais être déduites des mathématiques, ni d’une quelconque autre forme de langage. Dans le langage lui-même, elles se manifestent simplement sous la forme de reflets de singularités, telles que des discontinuités mathématiques ou d’autres ébauches paradoxales reflétées dans le médium du langage. L’existence ontologique de la singularité se situe à l’extérieur de la forme de génération de la marque en question, laquelle se trouve dans le domaine même du langage.

Ainsi, tout théorème qui prétend nier l’existence de discontinuités dans les mathématiques, tel que celui d’Euler, repose sur l’erreur de conception tautologique qui consiste à utiliser des constructions fondées axiomatiquement sur la linéarisation pour prouver une chose totalement inutile : que toute construction de ce type est incapable de reconnaître une quelconque forme d’existence mathématique qui n’est pas linéaire !

La discontinuité mathématique formelle appropriée, ou le paradoxe littéraire, n’est que la marque imprimée par la métaphore, à la manière d’une empreinte, dans le médium du langage formellement défini. La métaphore réelle que reflète la marque ébauchée ou le paradoxe, n’existe qu’à l’extérieur du médium. Elle se situe en trois endroits. Elle se situe d’abord dans la substance du processus que le langage essaie de décrire. Elle se situe ensuite dans les processus mentaux du scientifique, ou de l’artiste. Elle existe enfin dans les processus mentaux souverains des membres d’une audience qui répondent de manière socratique à la marque de la singularité, et cela en générant dans leur propre esprit une reproduction de l’idée qui a imprimé sa marque sur le médium de communication.

En physique mathématique, la validation des idées correspondant à de telles marques s’effectue généralement par des mesures qui démontrent que ces idées correspondent de manière efficiente à un effet ne correspondant pas aux vieilles idées que les nouvelles prétendent remplacer.

Il existe une illustration particulièrement remarquable de ce point dans le texte de Riemann intitulé « De la propagation des ondes aériennes planes d’amplitude finie » (1860). [27] Le fait que l’accélération vers des vitesses supérieures à la vitesse du son génère une singularité, était, pour Riemann, l’indication de l’existence des phénomènes transsoniques que Ludwig Pandtl et Adolf Busemann ont par la suite étudiés. C’est grâce à ce principe de Riemann, et l’intervention d’un spécialiste allemand de l’aéronautique, qu’a résulté le premier vol supersonique réussi d’un avion américain après la Deuxième Guerre mondiale. Cela a été réalisé en opposition à l’opinion erronée exprimée par de nombreux détracteurs des travaux de Riemann tels qu’Hermann Helmholtz, lord Rayleigh et Theodor von Karman. [28]

Dans l’exemple similaire relativement plus simple, celui d’Eratosthène, la validation empirique d’une telle singularité est effectuée par des mesures qui se situent dans le domaine des grandeurs arithmétiques. Cependant, ce n’est pas la seule forme primaire de preuve empirique d’une idée platonicienne. Comme l’illustre l’article de Riemann sur les ondes de choc, c’est l’existence d’une singularité non arithmétique, ayant une cardinalité précise mais pas de grandeur arithmétique, qui, dans certains cas, nous présente la forme mathématique de la preuve recherchée. Le fait que Riemann ait pu prévoir une classe de phénomènes dont le vol transsonique supersonique mentionné ci-dessus, ainsi que la compression isentropique dans l’ignition thermonucléaire, est un exemple de cela.

La caractéristique universelle de Leibniz

En ce qui concerne les implications ontologiques de la métaphore elle-même, Riemann met de l’avant dans ses documents posthumes un thème abordé auparavant par Leibniz et que j’ai moi-même repris ultérieurement. Nous devons considérer le fait que ces idées platoniciennes efficientes, reconnaissables en tant que découvertes de principes validées, sont générées dans les processus mentaux souverains de l’individu, lesquels sont inaccessibles aux moyens de communications symboliques comme les mathématiques formelles. Cependant, en dépit de la qualité éthérée que l’on serait tenté, à tort, d’attribuer à ces processus mentaux, le résultat de ces idées est une augmentation des pouvoirs physiques de l’espèce humaine à commander la nature en général.

A cet égard, ces textes de Riemann dirigent notre attention vers la notion leibnizienne de caractéristique universelle qui englobe à la fois les processus non vivants, les processus vivants et les processus cognitifs de notre univers. C’est le sujet dont il est question dans les deux premiers écrits posthumes Sur la psychologie et la métaphysique et Questions épistémologiques. Les travaux de Riemann publiés par la suite ne feront plus référence de manière explicite à ces fondements épistémologiques de la science. A partir de 1854, ses travaux publiés se limitent essentiellement à la physique mathématique, avec quelques incursions en biophysique [29], bien qu’il n’ait en aucune manière abandonné ce point de vue personnel dans sa réflexion sur les questions de physique mathématique. C’est là que réside l’importance particulière des écrits posthumes nous permettant d’identifier les implications plus profondes des travaux de Riemann dans leur ensemble.

Mes propres découvertes en économie physique trouvent leur origine dans la décision que j’ai prise étant jeune de suivre les traces de Leibniz et de développer une défense rigoureuse de Leibniz contre les attaques d’Emmanuel Kant. Cette défense est une question directement liée à la notion leibnizienne de caractéristique universelle. De plus, mes découvertes ont été provoquées à la fois par les excès positivistes de la théorie de l’information de Norbert Wiener et par l’incompétence similaire de l’analyse des systèmes de John von Neumann, l’un des associés de Wiener. J’ai considéré ces montages positivistes comme étant une pâle imitation de l’attaque de Kant contre Leibniz. C’est pour cette raison que j’ai relu Riemann, en ayant à l’esprit l’importance de la caractéristique universelle de Leibniz, cette notion que l’on retrouve dans les deux premiers écrits posthumes de Riemann.

Dans la théorie de l’information, l’imposture de Wiener se situe fondamentalement dans un usage illégitime de l’expression « entropie négative », qui avait été jusque-là surtout utilisée pour désigner la distinction qualitative entre processus vivants et processus non vivants tels qu’ils se présentent à l’échelle macro-physique. [30]

Dans une économie physique moderne qui fonctionne, mon champ d’étude, l’apparition biologique d’« entropie négative » s’accompagne de la condition suivante : le rapport entre « énergie libre » relative et « énergie du système » ne doit pas diminuer, en dépit de la condition supplémentaire selon laquelle l’intensité capitalistique et l’intensité de puissance augmentent par tête et par kilomètre carré. Ce résultat souhaitable est réalisé lorsque l’augmentation des pouvoirs producteurs (physiques) du travail est favorisée par l’investissement dans le progrès scientifique et technologique.

Je résume ci-dessous l’argument que j’ai élaboré à plusieurs reprises dans d’autres publications. [31]

En économie physique, le phénomène premier des processus économiques s’exprime en termes de paniers de biens, comprenant à la fois les biens physiques de consommation nécessaires et certaines classes de services indispensables, limitées essentiellement (dans la société moderne) à l’éducation, à la santé ainsi qu’à la recherche scientifique et technologique. Ces paniers de biens sont définis par tête (de force de travail), par ménage et par kilomètre carré du territoire en question. Ces paniers de biens sont définis pour la consommation individuelle, pour les processus de production et pour les améliorations du territoire que l’on désigne par « infrastructure économique de base ». L’économie physique exige une relation fonctionnelle entre le niveau de ces paniers de biens et les pouvoirs productifs du travail mesurés en termes de production et de consommation du contenu de ces paniers de biens. [32]

Cela nous conduit à une expression différentielle : quel niveau d’entrée (consommation) est requis pour maintenir un certain taux de sortie des produits nécessaires pour la consommation ? Sans toutefois connaître la réponse exacte à cette question à un moment donné, l’idée de la question est claire. Cette idée s’exprime convenablement par la notion de potentiel de densité démographique relative. [33]

Les niveaux de consommation des paniers de biens combinés qui sont requis pour maintenir au moins un certain taux constant de potentiel de densité démographique relative, sont assimilés à la notion d’énergie du système (Annexe 3). La sortie en excès du contenu des paniers de biens par rapport à ces niveaux requis est assimilée à l’énergie libre. On considère que l’énergie libre n’est pas « gaspillée » si elle est consommée sous forme de paniers de biens, à la fois pour étendre l’échelle de l’économie et pour augmenter le potentiel de densité démographique relative. Dans ce cas, l’intensité capitalistique (énergie du système par tête, par ménage et par kilomètre carré) doit augmenter, tout comme la densité de puissance. Le rapport de l’énergie libre apparente à l’énergie du système ne doit donc pas décroître en dépit d’une augmentation de la valeur relative de l’énergie du système par tête, par ménage et par kilomètre carré.

Si ces contraintes sont respectées, l’augmentation du potentiel de densité démographique relative est traitée, en tant que processus économique, d’une manière analogue à ce qui est exprimé en biologie comme l’auto développement évolutionniste de la biosphère selon une « entropie négative », et dans les termes de référence donnés par Vladimir Vernadski à la notion de biogéochimie. Pour éviter toute confusion avec le mauvais usage du terme « néguentropie » popularisé par la théorie de l’information, je préfère utiliser l’expression « entropie négative ».

Dans le champ de ce que Vernadski définissait comme étant la biogéochimie, c’est l’évolution de la biosphère qui doit conduire l’ensemble du système à un niveau supérieur d’organisation. L’argument de Vernadski s’inscrit parfaitement dans la tradition de pensée que l’on retrouve par ailleurs dans la notion de caractéristique universelle de Leibniz ainsi que dans les textes posthumes de Riemann.

Wiener a rendu les choses confuses en insistant de façon dérisoire sur le fait que l’entropie négative, pour laquelle il emploie le néologisme de « néguentropie », n’était rien de plus que l’inversion de l’entropie statistique décrite dans le théorème H de Ludwig Boltzmann. A l’opposé de la vision mécaniste de Wiener, si nous considérons l’humanité et son activité comme faisant partie du système planétaire, l’accroissement du pouvoir de l’homme sur la nature, exprimé par l’augmentation du potentiel de densité démographique relative [34], est réellement une augmentation de l’entropie négative ou de la « non-entropie » du système planétaire dans son ensemble. En d’autres termes, le développement de l’humanité fournit une impulsion de progrès à l’évolution de la totalité du système avec lequel l’humanité interagit.

De ce point de vue, la cognition humaine s’est développée dans le domaine des processus vivants. Toutefois, l’humanité, par ses caractéristiques écologiques entièrement dues à la cognition, se trouve absolument à part et au-dessus de toutes les autres espèces vivantes. Ainsi, notre univers subsume l’interaction entre trois types distincts de processus : le non-vivant, le vivant et le cognitif. Le principe commun subsumant qui gouverne cet univers est la notion leibnizienne de caractéristique universelle.

Si l’on partage l’opinion conventionnelle répandue aujourd’hui dans l’enseignement, ce que je viens d’énoncer provoquera immédiatement la question suivante : « Si la non-entropie de la société augmente, cela ne doit-il pas nécessairement se faire au prix de l’augmentation de l’entropie de l’univers avec lequel la société interagit ? » En d’autres termes, la relation de la société au reste de l’univers n’est-elle pas ce que les disciples de John von Neumann appellent un « jeu à somme nulle » ? Le cœur du problème est le suivant : l’idée d’« entropie universelle » ne résulte pas d’une découverte scientifique mais de l’application imprudente d’une vision du monde axiomatiquement linéaire et mécaniste, basée sur l’interprétation d’expériences à partir de modèles cinématiques des gaz.

La doctrine de la « loi de l’entropie universelle », et ses versions à la mode, est absurde car tout effort rationnel visant à décrire l’univers dans son ensemble, est un modèle d’évolution dans lequel le développement est représenté comme un progrès vers des états relativement supérieurs d’organisation. En termes mathématiques, ce progrès vers des états supérieurs d’organisation est indiqué par l’apparition de systèmes physiques dont on ne peut pas identifier les caractéristiques sans avoir recours à des mathématiques de cardinalités supérieures successives. En voulant expliquer la nature directionnelle efficiente de ces processus d’apparition de cardinalités supérieures, il devient absurde d’essayer d’expliquer l’existence de la matière dans les termes d’un dogme mécaniste d’« assemblage de briques ». Il est évident que pour reconnaître des états physiques de cardinalité supérieure, il faut transformer l’ensemble du système et non pas faire un agrégat d’objets d’un domaine mécaniquement fixe.

Dans le premier de ses textes posthumes, Riemann fait allusion à l’opposition mécaniste kantienne à ce point de vue développemental (par exemple non entropique). Comme dans le cas de l’attaque absurde d’Euler en 1761 contre la Monadologie de Leibniz, il est crucial de comprendre que la présupposition sur laquelle repose cette vision mécaniste kantienne, à partir de laquelle Rudolf Clausius, lord Kelvin et Hermann Grassmann ont concocté leur chimérique « Seconde loi de la thermodynamique » [35], est une « linéarisation axiomatique dans le petit ». Cela revient à créer une mathématique dans laquelle tout est subsumé par la supposition axiomatique selon laquelle tout, dans l’univers, est compatible avec la foi euclidienne aveugle en l’universalité de l’extension linéaire continue parfaite, y compris dans l’infiniment grand et l’infiniment petit. Les adeptes de cette foi considèrent comme « réfutée » toute formulation incompatible avec une telle « preuve » mathématique, et tout ce que l’on doit supposer pour préserver la cohérence du réseau de théorèmes de cette mathématique est considéré comme « prouvé » par les dupes et béni-oui-oui de l’autorité académique. [36]

A partir du moment où l’on se rend compte qu’une telle mathématique ne fournit aucun critère de preuve pour les questions en jeu, le verdict le moins sévère que les avocats de la « Seconde loi » pourraient obtenir de la part d’un jury rationnel, c’est le célèbre « not proven ! » des Ecossais. Aucun axiome d’aucune mathématique n’est prouvé en utilisant le réseau mathématique formel de théorèmes dont l’existence dépend de cette supposition.

Ces considérations nous permettent de situer le sujet dont il est question ici. Intéressons-nous maintenant à la caractéristique universelle de Leibniz.

Depuis les quelques millions de singes supérieurs à apparence humaine jusqu’aux milliards que nous sommes aujourd’hui, la forme paradigmatique de toute augmentation du potentiel de densité démographique relative de l’humanité consiste en une série de changements dans le comportement social et productif, dont la caractéristique est l’application générale des fruits du progrès scientifique et technologique. [37]

Chaque découverte est communiquée en reproduisant l’acte original de découverte dans l’esprit de l’auditeur. Si l’éducation des jeunes repose sur ce principe, la connaissance actuelle consiste en l’accumulation de toutes les singularités que les découvertes valides du passé ont transmises aux générations présentes. Les étudiants d’aujourd’hui seront ignares en matière scientifique tant qu’ils n’auront pas ré-expérimenté les découvertes originales des membres de l’Académie de Platon à Athènes, de Platon, d’Eudoxe, de Théétète jusqu’à Eratosthène. Sans une éducation classique des jeunes, s’inspirant des grandes œuvres classiques en matière de poésie, de tragédie, de musique et de science naturelle depuis les fondements de la civilisation moderne il y a deux mille cinq cents ans, il ne peut pas y avoir de véritable société civilisée ou même rationnelle – un fait dont nous faisons aujourd’hui cruellement l’expérience dans nos rues, dans nos gouvernements et dans nos universités.

Toute découverte valide de ce type fait appel au principe que nous avons associé ci-dessus au symbole topologique n → (n+1). Toute découverte est une singularité de ce type. Le progrès de la connaissance est une accumulation de ce genre de singularités. Comme Riemann le souligne dans ses fragments philosophiques, cette accumulation de connaissances est interactive, tout concept nouveau interagissant avec les autres concepts accumulés dans l’esprit de la même personne. Ainsi, avec chaque pensée, cette augmentation de singularités est reflétée de manière efficace : en termes mathématiques, la densité de discontinuités pour tout intervalle d’action humaine choisi arbitrairement est augmentée. C’est cette augmentation de « densité de discontinuités » qui caractérise la forme non entropique et la forme de l’action qui génère la non-entropie dans, par exemple, la forme d’augmentation du potentiel de densité démographique relative de la société.

Le fait crucial est que cette augmentation de la connaissance, telle qu’elle est ainsi définie, est efficiente de façon consistante. L’univers obéit aux ordres des pouvoirs mentaux créatifs de l’homme ! Donc, comme la Genèse 1 le prescrit, l’homme exerce sa domination sur la nature. Inversement, l’univers est manifestement constitué de telle manière qu’il est enclin à être soumis à l’autorité de ce pouvoir de raison créatrice qui est un potentiel propre à chaque individu humain.

En accumulant les expériences consistant à revivre les actes originaux valides de découvertes de principes, qui constituent l’accumulation de la connaissance jusqu’à aujourd’hui, nous apprenons à reconnaître les caractéristiques distinctives de cette forme d’actes de raison créatrice au moyen desquels les découvertes valides sont réalisées. Cette expérience qui nous devient ainsi familière, c’est ce que Kepler appelait la Raison et qui était pour Leibniz la raison nécessaire et suffisante. A partir du moment où nous admettons que le développement cumulatif de la connaissance représente la puissance de la volonté humaine à commander l’univers selon les lois de cet univers, nous comprenons que la raison telle que nous l’avons ainsi définie subjectivement, est aussi une approximation efficiente de la Raison telle qu’elle existe objectivement, en tant que principe efficient gouvernant l’univers dans son ensemble.

Ce que nous reconnaissons dans la forme de non-entropie, ainsi que dans l’augmentation du potentiel de densité démographique relative de la société, c’est la caractéristique de Raison, telle qu’elle existe de manière efficiente de deux manières : « objectivement » dans l’univers considéré dans son ensemble et, comme nous sommes capables d’apporter des principes de raison, « subjectivement » par l’efficience des découvertes valides de principes dans les domaines de la science et de l’art.

A partir du moment où cela est compris, il devient clair pour nous que l’univers n’est pas linéarisé dans l’infiniment petit ou l’infiniment grand. Il est non entropique, aussi bien dans l’infiniment petit que dans l’infiniment grand. Pour comprendre cela clairement, il suffit de refaire une lecture des contributions de Riemann à la physique mathématique, en évitant une vision étroite de la physique et en revenant au point de vue avantageux de Leibniz, au point de vue avantageux de l’économie physique, au point de vue avantageux de la relation efficiente entre raison humaine individuelle valide et augmentation du pouvoir de l’homme sur l’univers. Ainsi, on peut dire que la non-entropie, telle qu’elle est reflétée dans le type d’expression topologique riemanniene n → (n+1), correspond à ce que Leibniz appelait une caractéristique universelle.

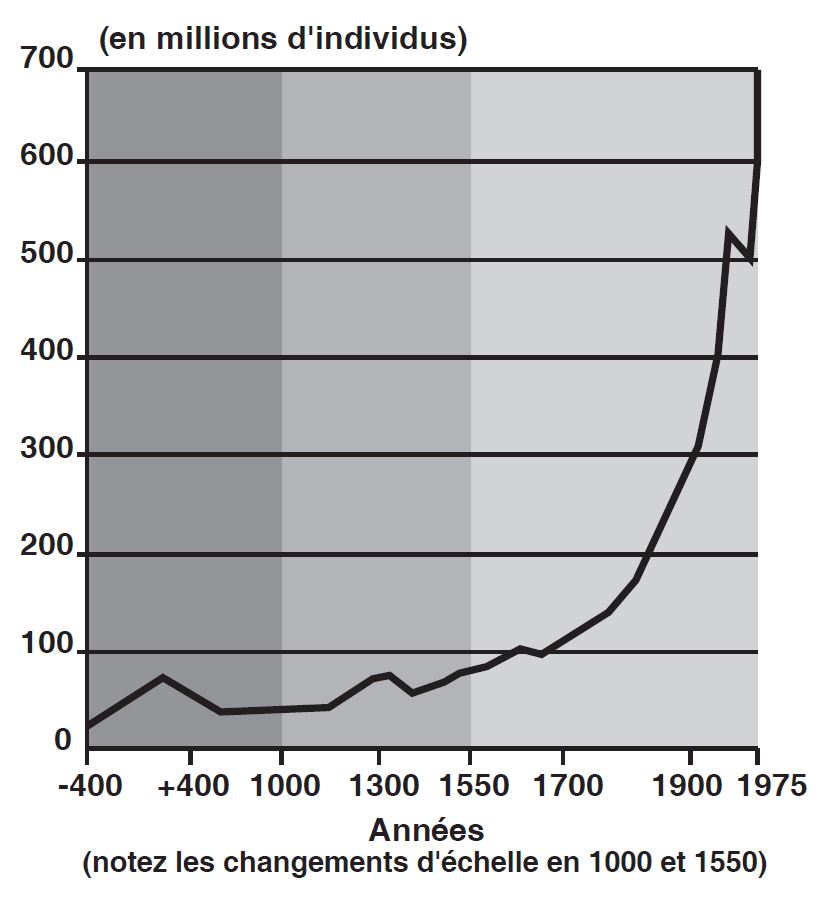

Annexe 3

Dans le tableau à droite, est représentée la croissance démographique européenne depuis la Rome antique. Ces augmentations successives dans le potentiel de densité démographique n’ont été possibles que grâce à une succession de découvertes scientifiques, transformant ainsi l’économie grâce à leurs applications technologiques.

Une économie « idéale » en croissance énergétique et capitalistique peut être représentée sous la forme d’une action spirale sur un cône hyperbolique (voir la représentation ci-dessous).

La vue latérale de celui-ci donne l’impression qu’il se projette vers « l’infini », sur des coordonnées cartésiennes. C’est, en fait, une singularité ou, en d’autres termes, une « discontinuité » mathématique dans le développement continu du processus économique.

Toutefois, le processus économique n’arrive pas à un point d’arrêt, il se poursuit mais il fonctionne sur une base métrique modifiée. Un nouveau cône hyperbolique est décrit avec le même résultat, et ensuite un troisième, et ainsi de suite.

Sur l’axe des temps (pour un cas idéal), les intervalles entre singularités diminuent, et ces intervalles progressivement plus petits décrivent une série harmonique.